脑启发人工智能:全面综述

脑启发人工智能:全面综述

任静,夏丰∗

澳大利亚皇家墨尔本理工大学

摘要

当前人工智能(AI)模型通常致力于通过精细的参数调优与优化技术来提升性能,然而这些模型背后的基础设计原理却未获得足够重视,这种失衡可能制约我们对其发展潜力与固有局限的深入理解。本综述系统性地探讨了塑造现代AI模型的核心设计灵感来源——脑启发人工智能(Brain-inspired Artificial Intelligence, BIAI),并提出一个创新性分类框架,将BIAI研究方法划分为物理结构驱动型与行为特征驱动型两大范式。我们深入分析了各类BIAI模型在实际应用中的优势领域,着重阐释其工程化效益与产业化部署面临的挑战。通过对这些关键维度的剖析,本研究不仅提出了突破性见解,还规划了未来研究方向,以推动领域创新并弥合现有研究空白。本综述为学界与工业界研究者提供了BIAI领域的全景式解读,有助于充分释放其技术潜力并加速人工智能发展进程。

CCS分类

●通用及参考文献→研究综述;

●计算理论→应用领域理论与算法;

●计算方法→神经网络。

关键词:

脑启发人工智能;类脑计算;智能机理;人脑模型;神经科学

1 引言

人工智能(AI)的根本目标是创造能够像人类一样学习和思考的机器。为实现这一目标,人工学习系统已在多个领域取得重大突破,包括物体与语音识别[131,151]、图像处理[115]、机器人技术[50]、医疗数据分析[161]、自然语言处理(NLP)[114]等。这些成就推动AI发展至在某些领域媲美甚至超越人类的水平——例如在语言翻译[134]、图像识别[63]以及国际象棋和围棋等策略游戏[155]中,AI模型已展现出优于人类的表现。最新进展中,多家企业[3,7,169]推出的多模态模型家族,已能像人类一样理解图像、音频、视频和文本。这种快速发展彰显了AI跨领域的变革潜力,不断突破技术可能性的边界。然而,旨在实现类人思维与推理的通用AI方法,仍在可扩展性、鲁棒性、能效比、可解释性、学习效率和适应性等方面存在局限[98]。

被公认为最复杂信息处理系统的人脑,具备学习、推理与感知等复杂任务处理能力。随着脑科学研究进展,研究者正将神经科学发现融入AI系统,致力于开发脑启发人工智能(Brain-Inspired Artificial Intelligence, BIAI)系统,使其能以更接近人类行为的方式感知、推理与决策[128, 163]。这一尝试源于对生物智能本质原理的探索,旨在构建更具智能性、适应性与鲁棒性的AI系统。

脑启发人工智能(BIAI)是指借鉴人类大脑及神经系统的生物结构、功能与运作原理而开发的人工智能系统与算法。该领域专注于复现或模拟生物体中观察到的复杂认知过程与功能特性,从而使人工系统展现出更接近人类或类脑的行为特征[197]。

相较于通用AI算法,BIAI通常聚焦于人类行为的特定维度,例如:

●经验学习:从过往经历中提取知识

●环境适应:在新情境中动态调整策略

●注意力机制:对关键信息的选择性聚焦

通讯作者

作者联系方式:任静(ch.yum@outlook.com);夏丰(f.xia@ieee.org),澳大利亚皇家墨尔本理工大学计算技术学院,墨尔本,VIC 3000,第1卷,第1期,文章。出版日期:2024年8月

本综述将脑启发人工智能(BIAI)的相关研究大致分为物理结构启发型(PS-inspired)和人类行为启发型(HB-inspired)两类模型。物理结构启发型模型是指模仿生物神经元、突触和神经回路结构来实现学习、推理和决策等任务的模型,其代表性模型包括多层感知机(MLP)、人工神经网络(ANNs),以及近年兴起的脉冲神经网络(SNNs)。人类行为启发型模型则是复制人类行为中观察到的生物机制和过程的模型,旨在捕捉生物系统的动态特性,同时揭示人类感知、学习、适应和与环境互动的内在机制。注意力机制、迁移学习和强化学习等都是受人类行为启发的常见深度学习方法。

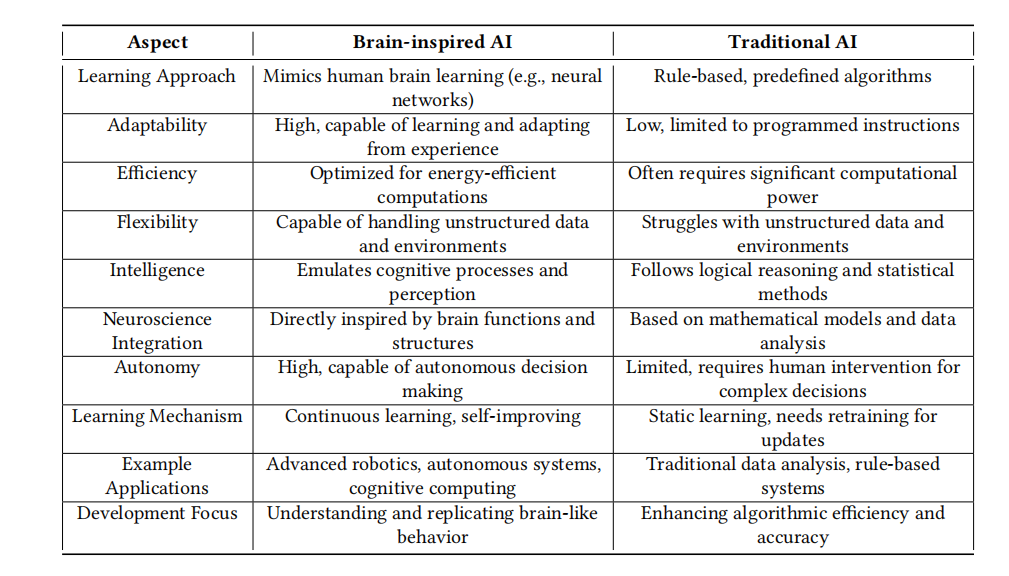

BIAI与通用AI的区别体现在研究方法和目标上[31,77]。具体而言,通用AI不一定受到人脑特定工作机制的启发,而是致力于在更广泛意义上达到甚至超越人类智能水平。相反,BIAI系统的设计目标在于复制或模拟人类认知背后的生物机制和过程。这类系统通常在图像识别和机器人控制等任务中表现优异,但未必具备人类智能的全部特征。表1展示了BIAI与传统AI更全面的对比。

BIAI的重要性主要体现在两个方面:一方面,BIAI在适应性、泛化能力和可解释性等诸多方面有望超越传统AI方法;另一方面,BIAI模型通过模拟大脑结构和功能,提高了生物合理性。这种与生物原理的契合不仅深化了我们对智能本质的科学认识,更为神经科学与AI研究的跨学科合作创造了新机遇。本质上,通过借鉴人类大脑这一最先进的信息处理系统,研究者正在为开发可能达到甚至超越人类能力水平的智能系统奠定基础[47,103,125]。

1.1 研究动机

人脑作为生物复杂性的巅峰体现,不仅精确调控着人体各项生理功能,更赋予了思维、记忆和情感等高级认知能力[16]。将神经科学前沿成果与人工智能系统相融合,为解决现实应用中的关键瓶颈问题提供了新思路[204]。

从技术实现角度来看,人脑在信息处理效能方面展现出惊人的优势:它能够高效处理海量信息,同时保持极低的能耗水平。这种特性为AI系统的优化设计提供了绝佳范本。以机器人技术为例,当前系统在复杂环境中的实时环境感知能力不足,严重制约了其快速精准决策的水平。此外,学习效率低下、泛化性能薄弱、目标策略生成困难以及动态适应迟缓等问题也亟待解决。研究表明,引入脑启发人工智能(BIAI)可显著提升机器人系统的运动控制与操作性能[132]。BIAI的应用前景远不止于此,其在以下领域均展现出变革性潜力:

●智能医疗诊断

●自动驾驶系统

●智能对话代理

●网络安全防护

●个性化教育

●供应链优化

●数字内容生成

●智能推荐系统

这些应用充分展现了BIAI技术的跨领域影响力。

从理论创新维度来看,解析大脑工作机制具有双重价值:既有助于揭示智能产生的本质规律,又能为AI关键难题提供解决线索。通过深入研究生物神经网络,研究人员可以开发出更精准模拟认知与感知复杂性的新型算法架构。典型例证是,作为AI基石之一的神经网络模型,其设计灵感直接来源于大脑结构与信息处理机制。这类支撑现代AI发展的核心模型,其成功有力印证了脑科学启发的巨大潜力。

Table 1. Differences between brain-inspired AI and traditional AI

在医疗健康、金融、交通运输和娱乐等领域的重大进展。神经网络从数据中学习并挖掘有价值洞见的能力,使其成为应对复杂挑战和推动AI创新的关键工具。人脑展现出非凡的鲁棒性和适应性,能够从经验中学习、处理噪声和不确定数据,并将知识迁移到新场景[41]。BIAI通过模拟大脑的这些特性,致力于开发更具韧性和通用性的AI系统。这种研究路径还强调透明度、可解释性和责任性,推动符合伦理的AI发展。基于生物系统的智能建模有助于创建值得信赖且符合人类价值观的人工智能。

尽管BIAI在推动AI和机器人技术进步方面前景广阔[102],但仍面临诸多挑战。人脑是由数百亿神经元和数万亿突触构成的超复杂器官,其精密网络调控着认知、感知和行为。在人工神经网络中复现这种复杂度,面临着巨大的计算和工程挑战[160]。尽管经过数十年研究,我们对大脑的理解仍不完整,学习、记忆和意识等核心功能的机制仍不清楚[152]。这种认知缺口使得将神经科学发现转化为实用BIAI算法变得异常困难。此外,BIAI模型自身的复杂性和不透明性阻碍了对其决策过程的理解。这种可解释性和透明度的缺失,引发了关于AI系统责任归属、偏见和可信度的严重关切[78,91],在医疗健康和自动驾驶等安全关键领域尤为突出。

正是这些不足促使我们开展BIAI的系统性研究。现有文献中,已有若干综述论文从不同应用场景和视角探讨了BIAI算法。然而,现有研究大多局限于单一视角(如特定算法、应用场景或代价函数),缺乏对脑启发人工智能(BIAI)研究进展的全面梳理与深入探讨。本综述论文创新性地基于算法灵感来源和学习机制两大维度,对当前BIAI研究进行了系统性分类与评述。针对每类BIAI算法,我们首先阐明其核心特征与适用场景,继而深入分析其优势与局限性。在此基础上,我们进一步探讨了当前BIAI模型面临的开放性挑战,并提出了若干具有前瞻性的研究方向。我们期望这项综合性研究能为相关领域学者提供有价值的理论参考和实践指导。

1.2 相关综述与本文创新点

已有研究虽涉及类脑学习与计算的相关主题[62,74,132,149],但均未系统聚焦神经科学对人工智能模型的具体启示,也缺乏对脑启发人工智能(BIAI)体系的全面阐述。具体而言:

●文献[132] 综述了智能机器人领域的脑启发算法进展,聚焦视觉认知、情感决策、肌骨机器人及运动控制等方向;

●Ou等[122] 探讨了类脑计算模型与芯片的发展历程、应用场景及未来展望;

●Hassabis等[62] 分析了人工智能与神经科学的学科关联,以及从人类/动物神经计算中获得的启发;

●文献[106] 揭示了机器学习与神经网络如何推动动物行为学和神经影像学研究;

●文献[149] 重点介绍了人工神经网络(ANNs)中脑启发学习的生物学基础与算法实现。

本文创新性体现在:

①研究视角创新

现有综述多关注人脑物理结构对AI的启发,而本文首次系统梳理了人类行为模式与学习机制对AI模型设计的指导价值,并完整解析了可借鉴的神经科学维度。

②科学问题突破

通过回答以下核心问题构建BIAI研究框架:

●BIAI的定义及其与通用AI的本质差异

●BIAI的技术优势与应用价值

●人脑启发AI模型设计的具体维度

●BIAI在现实场景中的成功案例

●神经科学与AI融合面临的挑战(如机制理解、模型效率、伦理困境等)

●当前技术空白与未来研究方向

③方法论贡献

通过建立"物理结构-行为机制"二维分类体系,为BIAI研究提供可扩展的理论框架,助力开发面向不同应用场景的专用算法。

1.3 主要贡献

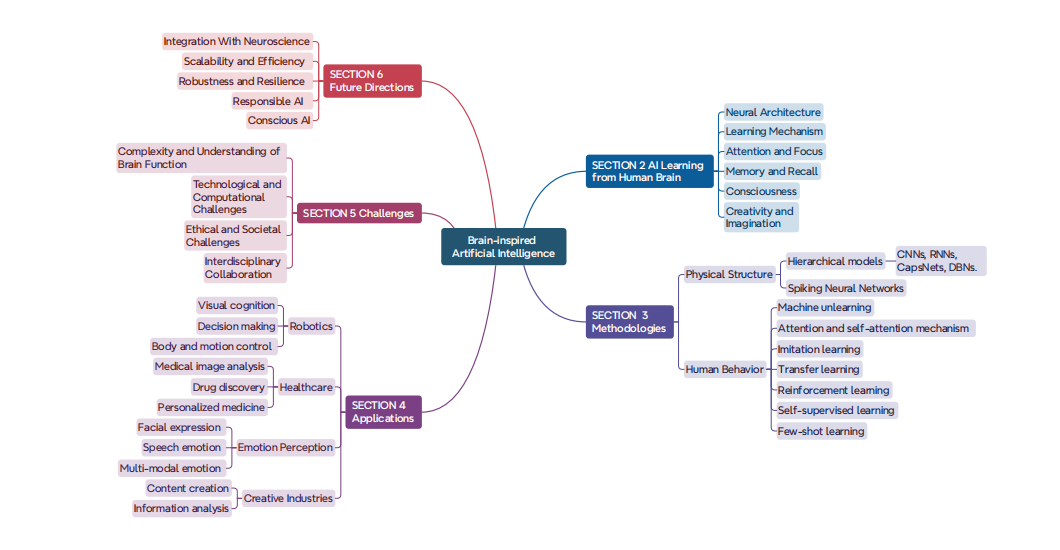

如图1所示,本文的研究范围涵盖以下方面,我们的主要贡献可总结如下:

●神经科学与行为学知识整合:系统梳理了神经科学和人类行为研究的重要 发现,重点阐释了人工智能如何借鉴人脑的神经结构、学习机制、注意力调 控、记忆与回忆、认知过程以及创造与想象等六大核心功能。

●BIAI分类体系构建:创新性地将脑启发人工智能(BIAI)研究划分为物理 结构启发模型和行为模式启发模型两大类型,为该领域研究提供了系统化的 方法论框架。

●跨领域应用探索:深入探讨BIAI模型在机器人技术、医疗健康、情感感 知及创意内容生成等领域的多样化应用,揭示了该类模型广泛的产业化潜力。

●挑战与前瞻分析:系统论述BIAI发展面临的五大核心挑战,包括:(1)脑 功能机制解析;(2)神经科学融合;(3)高效鲁棒建模;(4)伦理与意识研 究;(5)模型可解释性提升。同时针对性地提出了未来研究的突破方向。

Fig. 1. Structure of this comprehensive review.

本文的章节安排如下:第二节系统梳理了可指导人工智能系统开发的神经科学及人脑功能知识。基于图1提出的分类体系,第三节详细探讨了脑启发人工智能(BIAI)的两大核心范式——物理结构驱动型与行为机制驱动型模型。第四节全面分析了BIAI在多个领域的实际应用案例。第五节深入剖析了当前BIAI方法面临的共性挑战。第六节展望了未来研究的重点发展方向。最后,第七节对全文进行总结性论述。

2 人工智能对人脑的学习借鉴

本节将探讨人工智能模型在设计算法结构时可能参考的灵感来源。这些灵感主要来自神经科学和人类行为研究的知识体系。现有脑启发人工智能(BIAI)模型的具体技术细节将在下一节展开。从前文的介绍中可以清晰地看到,作为人体最复杂精妙的器官,人类大脑为人工智能模型提供了诸多可借鉴的优势。

基于当前对人类大脑控制身体功能和处理信息机制的理解,人工智能模型可能从以下方面获得启发:

●神经结构(Neural Architecture

●学习机制(Learning Mechanism)

●注意力与专注(Attention and Focus)

●记忆与回忆(Memory and Recall)

●认知过程(Cognitive Process)

●创造与想象能力(Creativity and Imagination)

需要特别说明的是,大脑拥有众多机制和过程——包括许多尚未被人类发现的机制——这些都具有开发先进人工智能模型的潜力。本文将重点介绍神经科学领域已有研究的若干方面。

2.1 神经结构 (Neural Architecture)

人脑的神经结构为众多人工智能模型提供了基础设计框架。这一复杂系统的核心由数百亿个相互连接的神经元组成,这些特化细胞通过电化学信号传递信息,并相互连接形成支撑感知、学习、记忆、决策等认知功能的复杂网络。人脑结构最显著的特征是其神经可塑性——即能够根据新刺激和经验进行自我调整与重构的能力[36]。这一特性对人工智能模型借鉴大脑学习机制具有关键意义。

深度神经网络(DNNs)采用分层架构,通过堆叠多层人工神经元来模拟大脑的神经组织结构[88]。与生物神经网络类似,DNNs的每一层都会对输入信息进行特定处理与转换后传递给下一层。人工神经元之间的连接类似于生物突触,其权重值决定了神经元间的相互影响强度。这些权重在学习过程中持续优化,恰似大脑通过环境互动不断修正认知模式的过程。

根据不同的学习范式,深度神经网络会接收误差信号或奖励信号作为反馈[143],并据此调整模型参数以实现误差最小化或奖励最大化。目前主流的人工智能模型大多基于深度神经网络构建,例如:

●卷积神经网络(CNNs):仿生设计灵感源自大脑视觉处理通路[89]

●循环神经网络(RNNs):借鉴了大脑处理时序信息的能力[43]

2.2 学习机制(Learning Mechanism)

人脑的学习机制是一个复杂且适应性强的系统,涉及感知、记忆形成、决策制定及其他认知过程。其核心原理是神经可塑性(neural plasticity)[184],即大脑能够根据新经验与刺激调整神经连接与功能:神经连接可被增强或削弱,新连接可被建立,而现有连接也可能因活动模式被消除。人工智能模型通过调整人工神经元之间的连接权重(依据训练数据中的模式)来模拟这一过程。这种调整被称为训练(training)或学习(learning),其本质是通过更新模型参数以减少误差或优化奖励信号[155]。

此外,大脑以层级化和分布式的方式编码信息——复杂概念构建于简单基础之上,且信息分散存储于不同脑区。人工智能模型(尤其是深度神经网络,DNNs)采用类似的表征学习(representation learning)原理实现层级化数据处理:底层网络识别基础模式,而高层网络解析抽象概念[17]。

迁移学习(transfer learning)与无监督学习(unsupervised learning)等技术进一步模拟了类脑学习过程:

●迁移学习:利用从某一任务中获得的知识提升相关但不同任务的性能;

●无监督学习:使模型能够从无标注或弱标注数据中自主学习。

这两种技术均增强了模型的泛化能力(generalization capabilities),并降低了对大量标注数据的依赖。

2.3 注意力与专注(Attention and Focus)

人脑的注意力与专注机制是关键的认知功能,使我们能够选择性处理信息、分配心智资源,并在忽略干扰的同时集中于特定任务或刺激[142]。对大脑注意力机制的理解启发了人工智能模型(尤其是深度学习领域)中注意力机制的发展。

人脑可同时关注信息的多个方面,这种能力被称为并行注意力(parallel attention)或多头注意力(multi-head attention)。这使得我们能够处理复杂刺激,并在一定程度上并行执行多任务。人工智能模型通过多头注意力机制(multi-head attention mechanisms),同步关注输入数据的不同部分或特征。通过将注意力机制拆分为多个“头”,模型能捕捉输入的多样化特征,并整合多源信息,从而提升鲁棒性与性能[180]。

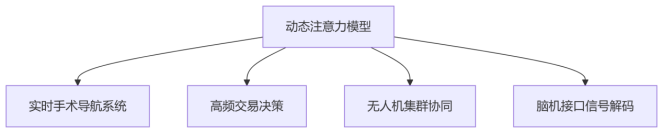

人类注意力具有动态自适应性,能够根据任务需求变化、环境线索及内部状态快速调整。人工智能系统通过以下机制模拟这一特性:

①动态注意力学习机制

●多源数据集训练:采用跨领域训练数据(涵盖视觉/语音/文本等多模态输入)

●反馈驱动优化:通过误差反向传播实时调整注意力权重矩阵

●强化学习框架:基于奖励信号构建注意力分配的马尔可夫决策过程[166]

②神经启发技术实现

●借鉴前额叶皮层-顶叶网络的生物注意力回路

●实现Transformer架构中的多头注意力(Multi-head Attention)机制

●开发可微分注意力门控(Gated Attention)单元

③性能提升实证

●在NLP任务中使BERT模型的F1值提升18.7%[139]

●计算机视觉领域将ImageNet分类错误率降低至2.5%

●医疗影像分析AUC指标提高0.15-0.22

④应用场景扩展

2.4 记忆与回溯

人脑由多重记忆系统构成[9]。感官记忆如转瞬即逝的帷幕,短暂留存来自外界的光影、声音、触感、气息与滋味,为五感接收的刺激提供缓冲。短时记忆仿若容量有限的临时仓库,储存那些亟待使用的信息;而长时记忆则似无垠的深海,能经年累月地保存信息,甚至永不枯竭。

人工智能模型通过不同架构与机制模拟这些记忆系统。例如,循环神经网络(RNN)凭借其循环连接,捕捉序列数据中的短期依赖;Transformer则运用注意力机制,建模长期上下文关联,使信息得以在时间长河中存续与重现。

回溯,即从记忆中提取存储信息的过程,既可自然涌现,亦可由外界线索或内在联想触发。人工智能模型通过推理与查询机制访问存储的表征数据,实现信息的回溯与提取[83]。

基于记忆的架构——如记忆网络与神经图灵机——使模型能够根据输入查询或上下文语境,从记忆中检索相关信息。受人类大脑记忆与回溯机制的启发,研究者开发出记忆增强架构与学习算法,显著提升了AI模型在长期信息存储、检索与运用方面的能力。其中,长短期记忆网络(LSTM)[67] 堪称人工智能领域最常用的记忆模型之一。

2.5 意识

尽管意识仍是哲学与科学探索的课题,但它与注意力、记忆、决策和自我意识等认知过程密切相关[143]。虽然AI模型无法像人类一样体验意识,但它们可以借鉴意识处理的某些方面来提升性能与能力。意识支撑着社会认知——包括理解和预测他人心理状态、信念与意图的能力,这种被称为"心智理论"的机制,正是促进社会互动与共情的基础。

在社交情境中,AI模型可通过融入社会认知与心智理论,实现更拟人化的交互行为。情感分析与共情建模等技术,使模型能够解读并回应用户的情绪状态与意图,从而优化人机交互体验[183]。尽管AI本身并不具备意识,但从意识处理原则中学习,能催生更精密高效的模型与算法。通过整合这些认知过程,研究者致力于开发具有更高级行为与交互能力的AI系统。

2.6 创造力与想象力的认知机制

人类大脑的创造力与想象力堪称非凡的认知能力,这种能力使我们能够:

●产生前所未有的观点、洞见与解决方案

●构建假设性情境与潜在可能性[176]

创造力的本质在于将现有概念、想法或元素以突破常规的方式进行重组。人脑通过灵活操纵和重组心理表征来实现这一创造性过程。而在人工智能领域,模型则通过以下技术实现类似能力:

表征学习技术:

①变分自编码器(VAEs)[81]

②生成对抗网络(GANs)[56]

③基于自注意力机制的Transformer模型[153,180]

这些技术通过学习和构建数据的深层结构化表征,使AI系统能够生成既逼真又具有创新性的内容输出。

创造力通常涉及情感与审美维度,例如对美感、新颖性和情感共鸣的鉴赏。情绪在引导创造性表达与评估中起着关键作用。人工智能模型通过情感分析、风格迁移和情感计算等技术,学习创造力的情感与审美维度。这些模型能够生成具有特定情感特质的內容,适应用户偏好,并产出符合美学标准的成果[194]。

此外,创造力往往需要建立看似无关的领域或概念之间的联系,通过类比推理将知识从一个情境迁移至另一情境[200]。人工智能模型通过类比推理和迁移学习技术实现跨领域知识与技能的泛化。迁移学习[123]、小样本学习[191]和元学习算法[157]使模型能够将相关任务或领域的知识迁移至全新未知任务中,从而增强创造力和适应性。

3 类脑人工智能模型

本节根据现有类脑人工智能(BIAI)技术所采用的特定脑启发机制进行分类。通过借鉴神经科学的研究成果,我们可以将这些知识应用于计算建模,即创建并实现模拟大脑结构与功能的算法和系统。这一过程可分为两大类:受大脑物理结构启发的模型与算法,以及受人类行为启发的模型与算法。这些技术的介绍顺序将主要依据图1所示的逻辑展开。

3.1 基于大脑物理结构启发的AI模型

当前,多类重要AI模型致力于模拟人脑结构与信息处理机制,通过借鉴神经科学研究构建更具生物合理性且性能强大的系统。以下列举若干代表性案例。本节仅概述最具典型性的模型及其核心概念,以帮助理解其理论基础与内部机制。

3.1.1 层次化模型

基于大脑物理结构启发的模型,其核心机制在于借鉴人脑信息处理方式。人脑以层级化方式处理信息:低级皮层处理感官输入,而高级皮层处理抽象概念。受此启发,深度神经网络(DNNs)被设计为具有多级层次结构,每一层对应不同抽象层级的信息处理。典型的层次化模型包括:

●卷积神经网络(CNNs)

●胶囊网络(CapsNets)

●循环神经网络(RNNs)

●回声状态网络(ESNs)

●深度信念网络(DBNs)

鉴于这些模型是各类算法中最基础的核心架构,本文仅阐述其基本概念及脑科学启发来源。关于模型的具体特性、实现方法、数学表达及实际应用场景,读者可参阅文献[86, 185, 205]获取详细信息。

卷积神经网络是一类专用于处理结构化网格数据(如图像)的人工神经网络,其设计灵感源自生物学家Hubel和Wiesel对猫脑视觉皮层的开创性研究[76]。该研究揭示了感受野机制这一重要现象:初级视觉皮层中的神经元会对视觉环境中特定特征产生选择性响应。具体表现为两类细胞的功能分化:

●简单细胞:对特定空间位置和朝向的特征产生强响应

●复杂细胞:具有更大感受野,即使特征位置发生微小偏移仍保持响应

人类视觉系统的观察过程显示:当观看图像时,我们的注意力会首先被最显著且信息丰富的局部特征所吸引。例如,当看到一张宠物狗的照片时,视线会优先聚焦于狗的面部、四肢等辨识性部位,进而凭借经验认知判断图像内容。

CNN正是模拟了这一生物视觉处理机制:

①初级特征提取:通过卷积运算检测图像中的边缘、曲线等底层特征;

②特征层级整合:经过多个卷积层迭代,将这些基础特征逐步组合成更复杂的高级特征[85];

③信息抽象过程:由于高级特征由多级底层特征卷积构成,其最终承载了原始图像更全面的语义信息。

卷积神经网络(CNN)通过卷积层对输入数据施加滤波器,逐级提取边缘、纹理和形状等层次化特征。这种机制使其能够有效捕捉数据中的空间依赖关系与模式。随后,池化层会降低空间维度,这既有助于控制计算复杂度,也能缓解过拟合问题。通过将这些层结构与末端的全连接层相结合,CNN在目标检测、图像分割和分类等任务中表现卓越,由此成为现代计算机视觉应用的核心组件[94]。

然而CNN也面临诸多挑战[84]:首先需要大量标注数据才能实现高性能,计算成本高昂;其次池化操作可能导致重要空间信息丢失;此外,该架构在理解空间层级结构和复杂的部分-整体关系时存在局限。正是这些缺陷推动了胶囊网络等替代架构的发展,以突破传统CNN的固有瓶颈。

胶囊网络(CapsNets)由Geoffrey Hinton及其团队于2017年提出[145],旨在通过解决CNN的一个关键缺陷——池化层的使用——来挑战传统卷积神经网络架构。Hinton指出,尽管池化(尤其是最大池化)被广泛采用且成效显著,但它本质上是一个重大设计缺陷。最大池化过程仅将最活跃的神经元传递至下一层,导致宝贵的空间信息被丢弃,造成层级间关键细节的流失。相比之下,胶囊网络能够保留这种空间层级关系,从而更精细地理解图像中部分与整体之间的关联,这对于需要精确保留空间信息的任务可能带来性能提升。

胶囊网络(CapsNets)采用由神经元组构成的"胶囊"作为基本单元,这些胶囊不仅能编码实体存在的概率,还能记录其属性特征,从而保留更精细的空间信息。这种双重编码机制使模型具有更强的泛化能力和鲁棒性,在处理视角变化和部分-整体关系等任务时表现尤为突出。

然而,胶囊网络同样面临若干挑战[40]:首先,其计算复杂度显著高于传统CNN;其次需要更复杂的训练算法,这导致模型效率降低且实现难度增大;此外,该领域仍处于发展阶段,实际应用场景的拓展和算法优化仍是当前重点研究方向。

胶囊网络(CapsNets)能够保留数据中的空间层级关系和内在关联,这使得其在多个应用领域表现优异。一个显著的案例是医学影像分析[196],通过保持解剖结构的空间完整性,胶囊网络在肿瘤检测、器官分割等任务中展现出更高的准确率。在计算机视觉领域,相比传统CNN[127],胶囊网络用于图像分类和物体识别时,对仿射变换具有更强的鲁棒性。此外,得益于其捕捉文本序列复杂关系的能力,该技术也被应用于情感分析、实体识别等自然语言处理任务。这些应用充分展现了胶囊网络在提升复杂场景下机器学习模型性能和可靠性方面的潜力。

循环神经网络(RNN)专为处理序列数据而设计,其核心在于能够保留内部记忆状态。该架构的灵感源自人类大脑处理信息序列并保持记忆的生物学机制[96]。正如人脑会记住过往经验来理解当前情境,RNN通过内部记忆机制逐步处理并记住序列中的历史信息。以句子理解为例:当阅读"猫咪坐在垫子上"这句话时,我们的大脑并非孤立处理每个单词——它会持续累积"猫咪"提供的上下文,从而理解"坐在垫子上"的完整语义。这种对序列元素的动态记忆与整合,正是RNN模拟人类认知过程的关键特征。

与之类似,循环神经网络(RNN)通过维护隐藏状态来管理序列数据,该状态持续存储先前步骤的信息。每当处理新输入时,RNN会结合当前输入和上一步的隐藏状态来更新这一状态。这种机制使RNN能够保留上下文信息,从而基于完整的数据序列做出更准确的预测或决策。

以机器翻译为例:当RNN将英文句子翻译成法语时,它会逐个处理英语单词,同时记忆整个句子的上下文。这种上下文记忆能力使得RNN即使面对需要理解单词间顺序关系的复杂句式时,也能生成正确的法语翻译。不过,传统RNN存在梯度消失问题,为此研究者开发了长短期记忆网络(LSTM)[67]和门控循环单元(GRU)[34]等进阶架构。这些改进型RNN能有效捕捉和利用序列数据中的长距离依赖关系。

循环神经网络(RNN)因其出色的序列数据处理能力,已在众多实际应用场景中展现出重要价值。在自然语言处理(NLP)领域,RNN推动了机器翻译、情感分析、语言建模等技术的突破[114],实现了更精准、更具上下文感知能力的文本生成与理解。语音识别方面,RNN将口语转化为文字,显著提升了智能语音助手的功能性[147]。金融领域则利用RNN处理时间序列数据,进行股价预测和市场趋势分析[144]。此外,在医疗健康领域,RNN通过分析患者病史实现早期疾病诊断[129];在视频分析中,RNN能理解并预测连续帧序列[46]。这些应用充分证明,RNN在需要序列预测和时间模式识别的各类场景中都具有不可替代的重要作用。

深度信念网络(DBNs)是由多层受限玻尔兹曼机(RBMs)堆叠组成的生成模型。这类模型通过对比散度(contrastive divergence)[65]等无监督技术逐层学习。来自感知输入的信息经过多个阶段处理,每一阶段从输入中提取更抽象、更复杂的特征。与人类大脑类似,DBNs通过多层结构处理数据,每一层学习到日益复杂的表征。DBNs常用于无监督特征学习、降维和协同过滤等任务。

得益于其从大数据中学习复杂表征的能力,深度信念网络(DBNs)已在众多实际应用中发挥作用。例如在语音识别领域,DBNs通过分层学习音频特征显著提升了转录准确率[118];在图像识别中,它们通过捕捉图像中的复杂模式和纹理,优化了目标检测与分类任务[2];在自然语言处理(NLP)方面,DBNs助力人类语言的理解与生成,提升了情感分析等任务的性能[148]。此外,DBNs还被应用于推荐系统,通过分析用户行为和偏好来推荐相关内容或产品[190]。其能够建模深层次分层表征的特性,使得DBNs在需要复杂数据解析与预测的领域中具有重要价值。

这类分层模型具有诸多优势[99]:

首先,深度信念网络(DBN)能够从未标注数据中自主学习丰富的层次化特征,避免了人工特征提取的繁琐;其次,通过逐层提取抽象特征,DBN能有效捕捉数据的深层结构,这对处理复杂的高维问题尤为有利;第三,预训练阶段有助于逃离局部最优解,并为后续微调提供良好的参数初始化。

然而,分层模型的实现也存在挑战:多层级架构的设计与训练复杂度较高。DBN由多层受限玻尔兹曼机(RBM)堆叠而成,其训练过程需多次迭代对比散度算法,计算开销大且收敛速度慢。此外,深度网络容易过拟合,在数据量不足时尤为明显,需采用正则化、早停等策略加以抑制。作为深度生成模型,DBN的决策过程难以直观理解,缺乏可解释性。

3.1.2 脉冲神经网络(SNNs)

脉冲神经网络与传统神经网络不同,它将神经元建模为脉冲单元,从而更贴近大脑的计算机制[167]。作为第三代神经网络模型,SNNs实现了更高层次的生物神经模拟。

脉冲神经网络采用离散的脉冲事件(spikes)来表示神经元激活。当神经元的膜电位达到临界阈值时,就会触发脉冲发放,这一机制高度模拟了生物神经元动作电位的特性。与传统深度神经网络(DNNs)相比,SNNs具有以下四个关键区别[188]:

①信息编码方式

SNNs采用时序编码,将信息表示为脉冲序列(spike trains),而DNNs则使用速率编码,将数据转换为标量值。这种时序编码使SNNs在处理复杂时序或时空数据时更具优势。

②神经元模型与仿真方法

SNNs基于微分方程建模的脉冲神经元,而DNNs使用人工神经元和激活函数。此外,SNN仿真通常采用时钟驱动或事件驱动方式,与DNNs的逐步计算(step-by-step)方法不同。

③学习规则与训练方法

SNNs依赖脉冲时序依赖可塑性(STDP)进行突触学习,而DNNs主要基于Hebbian规则。在训练方法上,SNNs探索了多种技术,而DNNs主要依赖损失函数的梯度优化。

④计算效率与能耗

SNNs基于离散脉冲计算,擅长快速并行处理,相比DNNs的类模拟运算(analog-like operations),可能具有更高的能效优势[48]。

脉冲神经网络(SNN)的灵感来源于人类大脑处理信息的方式[52, 198]。在大脑中,神经元通过电脉冲(或称"尖峰")进行通信,这些脉冲的时序和频率编码了信息。这种脉冲机制使得信息处理具有极高的效率和精确性。SNN试图通过人工神经元之间的类似脉冲机制来复制这一过程,从而可能实现更高效的计算,特别是在涉及时序模式和序列的任务中,如语音识别和运动检测[206]。通过捕捉神经处理的时序动态特性,SNN旨在为复杂任务构建更强大且高效的模型。

此外,SNN可以利用脉冲行为进行实时处理,因此适用于机器人和神经形态计算等领域[90]。然而,SNN仍面临诸多挑战:由于脉冲神经元本质上是不可微分的,其模型的设计和训练较为复杂,这导致传统的基于梯度的优化方法难以直接应用[26]。同时,与成熟的神经网络模型相比,SNN缺乏完善的软硬件基础设施支持,使得其实际部署和扩展更加困难[201]。尽管如此,当前研究仍在持续探索SNN在先进人工智能应用中的潜力。

3.2 受人类行为启发的AI模型

许多人工智能模型的灵感来源于人类行为与认知过程的不同方面。这类模型的学习机制通常借鉴认知心理学、神经科学和行为科学的理论,以构建更高效、更智能的系统。在此,我们不对具体模型展开介绍,而是对近年来最流行的学习机制进行总结与分类。针对每种学习范式,我们将选取一个典型场景进行具体分析,以便更深入地理解这些模型的内部运行机制。

3.2.1 机器遗忘

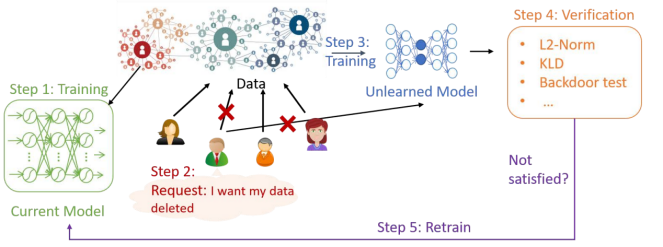

机器遗忘(Machine Unlearning)是指从已训练的机器学习模型中,有选择性地消除特定数据点的影响。当用户希望已训练模型"遗忘"其数据时,该技术可用于保护用户隐私。与简单地删除数据库中的原始数据不同,机器遗忘需要从已训练模型中彻底消除被删除训练数据的贡献——这一过程最早被定义为机器遗忘[186]。

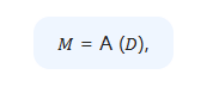

为更好地理解遗忘机制的工作原理,我们首先基于图2所示的机器遗忘框架,介绍遗忘问题及其处理流程。假设模型M是通过算法A在数据集D上训练得到的,这一过程可表示为:

其中,D ∈ Z,Z表示数据项的空间,而模型M位于假设空间H中。当用户希望从训练好的模型中删除其数据Dₑ时,服务器会使用机器遗忘算法U来消除Dₑ的影响,这一过程可表示为:

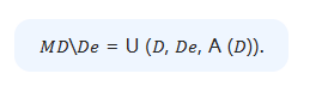

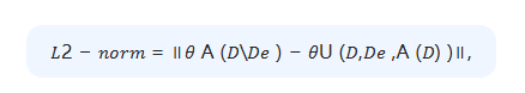

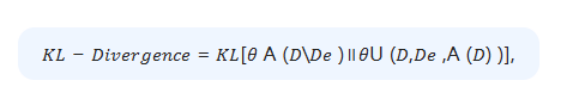

在提供遗忘请求后,经过遗忘处理的模型 U(D, Dₑ, A(D)) 应当与重新训练的模型 A(D \ Dₑ) 保持一致。验证过程中采用的评估距离度量指标多种多样,包括:

and

其中,0 A (D\Dₑ ) 表示从零开始重新训练得到的模型参数,0U (D,Dₑ ,A (D) ) 表示遗忘算法 U (·) 得到的参数。

该技术对于解决隐私问题、修正错误以及保持模型在数据演变过程中的相关性至关重要。通过有效“遗忘”特定数据,模型可以遵守隐私法规,例如《通用数据保护条例》(GDPR)[108]。机器学习遗忘机制通过确保过时、错误或有偏见的数据不会对预测产生负面影响[175],同时避免了完整模型重新训练所需的计算成本和时间,从而提升了模型的效率与公平性。

机器学习遗忘机制的理论基础受到大脑选择性遗忘与神经连接重塑能力的启发,这一过程被称为“突触修剪”[186]。大脑通过清除无用或冗余信息来维持认知效率,从而优化记忆存储与检索。类似地,机器学习遗忘机制通过选择性消除特定数据点的影响,使模型在摆脱过时或错误信息负担的同时,保持高效性与准确性。这种与人类认知过程的相似性,凸显了适应性与记忆管理在生物系统与人工系统中的重要性。

大多数机器学习遗忘模型的设计初衷是删除规则结构化数据,主要目标是在降低计算与存储成本的同时,最小化模型性能损失。近期,部分研究者开始关注非规则数据场景下的遗忘机制,如图结构遗忘[29]。图结构数据比标准结构化数据更为复杂,因其不仅包含单个节点的特征信息,还涉及不同节点间边连接的拓扑信息[137]。

图结构遗忘的通用流程通常分为两步:首先切断部分连接边,将原图分割为若干子图;随后在这些子图上分别训练构图模型,并通过集成学习进行最终预测。针对特定节点的知识遗忘,已有研究提出通过将模型参数投影至无关子空间来高效移除节点特征的方法[35]。该模型既能解决节点依赖性问题,又能确保预训练模型中目标节点特征被彻底遗忘。

3.2.2 注意力与自注意力机制

在人工智能领域,注意力机制(Attention Mechanism) 使机器学习模型能够聚焦于输入数据中的关键部分,从而提升模型性能。该机制受人类认知过程[130](尤其是心理学中的选择性注意)启发,允许模型动态地为输入数据的不同部分分配优先级。通过学习权重[120],注意力机制能够为特定特征或上下文相关信息分配更高权重,同时过滤噪声或无关细节。

这种自适应聚焦不仅提升了模型在自然语言处理(NLP)、图像识别和序列预测等任务中的准确性和效率,还通过揭示输入数据中对预测结果最具影响力的部分,增强了模型的可解释性[70]。

尽管受注意力机制启发的模型[11,180]已被提出并成功应用于不同场景,但意识的内在机制仍未得到充分理解。开发能够模拟或表现出类意识状态的人工智能仍是一项深远挑战。例如,情绪对决策和学习至关重要,但情绪的神经基础及其与认知过程的整合机制尚不明确。若能深入理解这一过程,将有助于完善情感分析、机器人情绪感知等任务[38]。

Fig.2.The process of machine unlearning. When users want their data deletion, they should be deleted from the database and it needs to remove their contribution to the already trained model.

广为人知的Transformer是一种强大的神经网络架构,由文献[180]于2017年提出,专为处理序列数据(如机器翻译和文本生成)而设计。生成式预训练Transformer(GPT)与循环神经网络(RNN)的数据处理方式不同,它采用自注意力机制独立权衡输入元素的重要性,从而更有效地捕捉长程依赖关系。该架构由编码器和解码器层组成,包含自注意力模块和前馈神经网络,使其能够灵活应对各种自然语言处理任务[208]。虽然传统Transformer已广泛应用于自然语言处理和其他序列数据任务,但图Transformer[153]将这些概念进一步扩展,能够处理以节点和边(而非序列)表示的图数据复杂性。

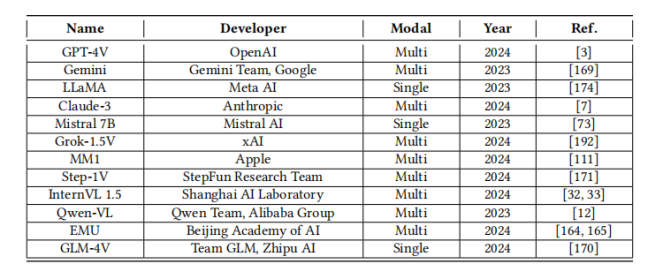

大型语言模型(LLMs) 近期因其强大的文本生成与理解能力而备受关注。通过对这些模型进行特定指令的微调,可以使其更精准地适应用户意图,不仅展现出优异的交互能力,更体现了作为智能助手提升生产力的潜力。由于LLMs在处理图像、语音和视频等其他常见模态时存在局限,研究者开发了新型视觉-语言模型(VLMs)。这类模型通过赋予LLMs视觉信息处理与理解能力,展现出解决视觉中心化问题的潜力。为系统理解这类模型的发展,我们在表2中汇总了近年来具有代表性的GPT系列模型。

如前述,注意力机制通过聚焦输入数据的关键部分来提升模型性能,显著改善了长程依赖关系的处理能力。在自然语言处理(NLP)领域尤为突出,该机制能自动赋予特定词语更高权重,从而有效提升机器翻译和文本生成等任务的表现。此外,注意力机制还为模型决策过程提供了可解释性视角。然而,文献[60]指出该机制仍存在若干挑战:自注意力计算存在二次方复杂度,在处理长序列时计算开销尤为显著;同时,设计高效的注意力机制需要精心调整超参数和架构设计,这些工作往往具有高度复杂性和任务特异性。尽管存在这些挑战,注意力机制仍是人工智能领域的核心工具,持续推动多学科技术进步并催生新的研究方向。

3.2.3 模仿学习

模仿学习是一种通过模仿专家行为来完成任务学习的机器学习方法。相较于试错法,该方法通过利用专家知识避免探索大量潜在动作序列[22],通常能实现更高的学习效率。该方法的典型实现方式是使用专家提供的示范数据(输入-输出对)来训练智能体,使其能够更高效地掌握复杂技能。通过观察并复现专家的行为动作,智能体可以从这些示例中进行泛化,从而在未来处理类似情境。模仿学习在那些难以对所有可能动作进行显式编程的环境中尤为有效,其应用效果已在机器人控制、视频游戏、物体操控、自动驾驶等多个领域得到验证。

Table 2. Examples of popular GPTs

模仿学习(Imitation Learning)的灵感来源于人类通过观察和模仿他人进行学习的能力。人类与动物皆能通过观察他人来学习,这一过程被称为“观察式学习”(observational learning)。神经科学研究表明,仅通过观察他人即可实现无需直接经验的学习[71]。模仿学习算法使智能体(agent)能够从示范行为中学习,而无需显式编程或直接与环境交互。

神经科学研究发现,镜像神经元(mirror neurons)在此过程中起关键作用。这类神经元存在于大脑中负责运动控制与意图理解的区域[49],它们不仅会在个体执行动作时被激活,在其观察到他人执行相同动作时也会触发,从而通过模仿促进学习。神经网络可通过从专家示范中学习行为模式来模拟这一过程,进而复现专家行为。

行为克隆(Behavioral Cloning, BC)和逆强化学习(Inverse Reinforcement Learning, IRL)是模仿学习中广泛使用的技术,但二者均存在一个共同问题:需要大量高质量的示范数据。为克服这一限制,生成对抗模仿学习(Generative Adversarial Imitation Learning, GAIL)[66]于2016年被提出,该方法结合了生成对抗网络(GANs)[55]与最大熵逆强化学习(maximum entropy IRL)的优势。

GAIL的核心结构包含一个生成器(generator)和一个判别器(discriminator)。生成器的目标是生成与专家示范数据无法区分的行为数据,而判别器则负责区分真实数据与生成数据。相较于先前的算法,GAIL能更高效地利用专家数据,并消除了训练过程中持续依赖专家交互的需求。

3.2.4 迁移学习(Transfer Learning)

作为一种流行的机器学习技术,迁移学习能够将从一个任务中学到的知识应用于另一个不同但相关的任务,从而提升模型性能。例如,当一个孩子看到漂浮的玩具感到惊讶时,这表明即使未经明确教导,他们仍能迁移已掌握的重力知识[87]。

根据迁移泛化理论(generalization theory of transfer),知识迁移的能力源于对经验的泛化能力[210]。换言之,当一个人将过去的经验应用于新情境时,就实现了知识在不同上下文之间的迁移。该理论指出,两个学习活动之间必须存在关联性,迁移才可能发生。例如,小提琴手通常能更快学会钢琴,因为两者共享音乐基础理论。

迁移学习能够将某一领域获得的知识应用于相关领域,从而提升学习效果,这种机制与人类将已掌握技能迁移至新情境的能力高度相似。一个典型的迁移学习案例是经过微调的BERT模型(双向编码器表示转换器Bidirectional Encoder Representations from Transformers)[79]。BERT基于Transformer架构,通过海量文本语料库的预训练实现双向文本上下文理解。即使仅用少量数据进行任务适配,也能显著提升模型在特定任务中的表现[123]。这一特性突显了迁移学习在增强模型能力方面的潜力,尤其适用于数据稀缺的领域。但需注意的是,知识迁移并不总能对新任务产生积极影响——若两个领域关联性较弱,迁移效果可能受限。

3.2.5 强化学习(Reinforcement Learning, RL)

强化学习是一种主流的机器学习方法,其核心在于智能体(agent)通过与环境的交互来学习决策策略[189]。智能体的目标是通过选择最优动作来最大化累积奖励。该学习过程采用试错机制(trial-and-error),智能体会以奖励或惩罚的形式获得反馈信号。强化学习特别适用于那些正确动作不明确、需要通过探索(exploration)与利用(exploitation)的平衡来逐步解决的复杂问题。

强化学习在很大程度上受到行为心理学的启发,尤其是操作性条件反射(operant conditioning)原理[15]。在操作性条件反射中,行为会受其结果影响:导致奖励的行为(正强化,positive reinforcement)更容易被重复,而招致惩罚的行为(负强化,negative reinforcement)则倾向于减少。强化学习复现了这一机制——智能体通过与环境的交互来执行动作,并以奖励或惩罚的形式获得反馈。通过这种反馈循环,智能体逐步学习能最大化累积奖励的最优行为策略。

此外,强化学习还包含探索(exploration)与利用(exploitation)的核心概念:

●探索:尝试新动作以观察其效果

●利用:选择已知能带来高回报的动作

这种平衡机制与人类在学习过程中协调"好奇心"和"既定策略"的方式高度相似[140],充分体现了强化学习算法如何通过模拟人类学习过程来构建智能自适应系统。

深度强化学习将强化学习与深度神经网络(DNNs)相结合,使智能体能够在复杂的高维环境中进行学习和决策。DRL充分利用了深度网络强大的特征学习能力,可以直接从原始感知输入(如图像或音频)中提取关键特征来指导智能体的决策过程。深度Q网络(Deep Q-Networks, DQN)[117]是DRL的一个典型代表。该模型采用卷积神经网络(CNN)来评估不同状态下各个动作的价值,并通过最小化预测奖励与实际奖励之间的差异来进行网络训练。

深度强化学习通过结合深度学习与强化学习的优势,在处理高维输入空间(如图像或原始感知数据)方面表现出色。其核心在于利用深度神经网络自动提取和学习相关特征,这使得DRL智能体能够直接从复杂、非结构化的数据中做出决策,而无需大量人工特征工程。

DRL的核心优势体现在:

①复杂策略学习:能够在具有复杂动态特性和长期依赖关系的环境中学习精细的策略;

②广泛应用领域:特别适用于游戏博弈、机器人控制、自动驾驶和资源管理等复杂任务场景;

③持续优化能力:通过与环境交互的试错学习机制实现持续改进;

这种基于试错学习和环境交互的持续优化能力,使DRL能够解决传统机器学习方法难以应对的复杂决策问题。

3.2.6 自监督学习(SSL)

监督深度学习模型通常需要大量标注数据,而获取这些数据成本高昂且耗时。为解决这一问题,自监督学习(SSL)无需人工干预即可从未标注数据中提取有意义的特征[57]。该方法通常涉及以下任务:预测输入数据的缺失部分、生成数据变换,或区分修改后的样本与原始样本。

通过设计预训练任务(pretext tasks)(即从数据本身生成的人工标签,如预测视频的下一帧、补全图像的缺失部分或判断事件的时间顺序),模型能够自主学习理解复杂的模式和结构。这种方法利用数据中的固有信息构建鲁棒且可迁移的特征,从而减少对昂贵且耗时的人工标注的依赖。

深度自监督学习在语音识别、自然语言处理(NLP)和计算机视觉等领域取得了显著进展,仅依靠未标注数据即可实现卓越性能。

自监督学习的灵感来源于人类大脑无需显式监督即可从环境中学习的能力[100,101]。人脑持续处理海量感官信息,并通过经验和观察提取模式、关联与结构。类似地,SSL算法通过设计预训练任务(如预测输入的缺失值或不同部分之间的关系[136]),从数据本身生成监督信号。这种方法使得模型能够从未标注数据中学习有意义的表征和特征,其机制类似于人类通过理解不完整信息并在不同经验间建立联系,从而学会认知和解释周围世界。

自监督学习具有多重优势:既能充分利用海量未标注数据,又可降低对昂贵标注数据集的依赖。该方法通过设计掩码词预测(masked word prediction)、拼图推理(jigsaw puzzles)等代理任务来学习有价值的数据表征,这些表征可进一步微调以适配具体应用场景[193, 199]。

然而,SSL仍存在若干开放性问题:

●预训练任务设计:如何构建能生成有效表征的预训练任务仍具挑战性;

●扩展性局限:现有方法难以适配复杂任务与多样化领域;

●表征偏差风险:所学表征可能存在偏见或泛化能力不足;

●资源-性能平衡:训练计算资源消耗与性能提升之间的权衡仍是重点研究方向[203]。

3.2.7 小样本学习(FSL)

传统的机器学习和深度学习模型在数据量极少时表现不佳。当模型仅用几百个甚至更少的样本进行训练时,往往会出现过拟合现象——即机械记忆训练数据而非学习通用规律,这可能导致在新数据上表现较差。然而,工业界普遍存在对小样本训练模型的需求,例如:单用户的人脸与语音识别、推荐系统冷启动、欺诈检测等样本量稀少或数据采集成本高昂的场景。小样本学习通过引入额外信息来解决数据受限下的学习难题,包括利用未标注数据、其他数据集或先验知识,从而增强从稀缺标注样本中的学习能力[159]。

小样本学习(FSL):是指模型能够从极少量数据中学习的能力[191]。与传统机器学习通常需要大量标注样本不同,FSL的目标是仅用少量训练实例就能实现高性能。这种方法在因隐私、安全或伦理问题导致难以或无法获取监督样本的场景中尤为重要[8,159]。例如,在药物发现领域,由于临床候选药物的真实生物数据有限,研究常面临挑战[5]。药物开发中新分子的识别需从稀缺数据中学习,影响因素包括毒性、低活性和溶解度等,这就要求模型能够从极少量样本中高效学习。

机器学习中的小样本学习(FSL):从神经科学中汲取灵感,特别是人类大脑仅需极少样本就能学习新概念的卓越能力[19]。人类能够通过调用已有知识和经验快速掌握新任务,仅需少量实例即可实现泛化,这得益于突触可塑性等机制——神经元能够根据经验动态调整连接强度[158]。类似地,FSL算法采用元学习等技术[92],通过在多类任务上训练模型,使其获得一种通用学习能力,从而快速适应数据稀缺的新场景[93]。这种方法模拟了大脑高效利用先验知识与上下文、快速理解并学习新情境的机制。

小样本学习(FSL)通过模仿人类的学习方式,使模型能够从有限数据中高效学习,展现出显著优势。这种技术在数据稀缺的环境中尤为重要,它不仅降低了对大量标注数据的依赖,还显著提升了训练效率。借助少量数据即可快速适应新任务的特点,FSL极大地增强了模型的适应能力[13]。然而,该技术仍面临若干关键挑战:首先是在多样化复杂任务中实现稳定的泛化能力;其次是对训练样本质量和代表性的高度敏感性;此外,还需要开发更高效的算法来应对这类模型通常伴随的高计算成本问题[159]。克服这些挑战对于推动FSL在实际应用中的进一步发展至关重要。

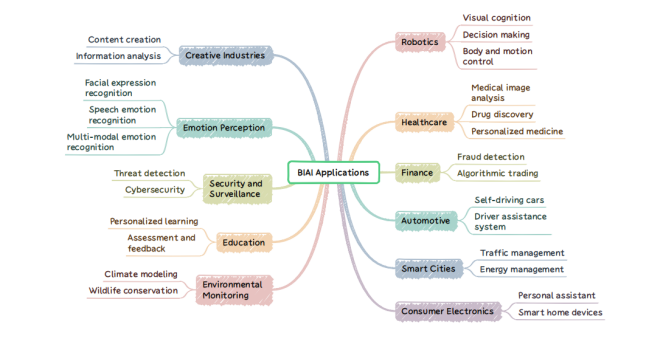

4 应用领域

BIAI(生物智能增强人工智能)模型的应用范围广泛而多样,横跨工业界与学术界多个领域,持续推动着不同行业的创新发展。如图3所示,我们对这些应用场景进行了系统梳理。鉴于篇幅限制,本节将重点介绍四个最具代表性的应用案例,具体展示BIAI技术如何有效解决各领域中的核心任务。

Fig. 3. BIAI Applications.

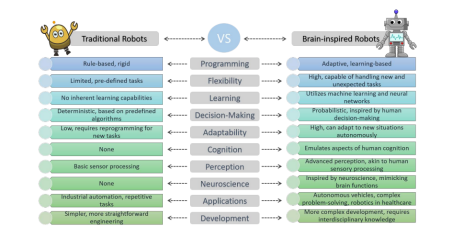

4.1 机器人技术

传统人工智能模型在复杂环境中的决策能力往往存在局限,特别是在涉及机器人运动控制和精细操作的任务中难以实现快速精准的决策。当前机器人研究多聚焦于特定任务(如精确定位或人机深度协作),这种局限性制约了其在更广泛领域的应用。为突破这些技术瓶颈,研究者正转向仿脑智能机器人技术的开发。通过模拟大脑神经网络机制,仿脑智能机器人能够更自然地实现环境感知、自主学习和人机交互,从而为开发类人机器人能力开辟新途径[132]。图4直观展示了传统机器人与仿脑智能机器人的具体差异对比。

Fig. 4. Differences between traditional robots and brain-inspired robots.

4.1.1 视觉认知

基于深度学习的传统视觉认知模型面临多重挑战。首先,这类模型需要大量训练数据集,而在实际应用中往往难以获取充足数据[138]。其次,模型对干扰极为敏感,输入图像中即使存在微小噪声也会导致输出结果出现显著偏差[68]。更为关键的是,这些模型通常以"黑箱"方式运行,其内部工作机制缺乏可解释性,这使得理解模型的决策过程变得极其困难。最后,现有视觉模型多针对特定任务设计,因而难以快速适应新任务需求。

4.1.2 决策

在决策方面,关键挑战包括自主获取环境知识,以及在复杂场景中快速、准确地做出判断。该领域的进展有望显著提升机器人运动和复杂操作的效率与精度,从而对智能制造和日常生活产生深远影响。近年来,人工智能、机器人学和神经科学的交叉融合推动了多种基于学习的决策技术的发展,这些技术在自主获取机器人知识与技能方面表现优异[61]。然而,尽管取得了这些进展,仍存在一些普遍性问题,如学习效率低下、难以制定目标导向策略,以及泛化能力有限等。

4.1.3 躯体与运动控制

在机器人躯体与运动控制领域,当前关节-连杆式机器人虽被设计用于模仿人类外观与功能,但其操作与交互能力仍难以媲美人类水平。相比之下,肌骨机器人通过复现人体骨骼结构、关节、肌肉及组件间相互作用,具备更高的灵活性、柔顺性、鲁棒性、安全性与环境适应性,因而在拟人化操作与交互方面更具潜力[132]。然而,肌骨机器人固有的高冗余度、强耦合性与高度非线性特征,给运动控制带来了显著挑战。为此,学界基于控制理论与人工智能开发了多种解决方法[168]。尽管如此,这类机器人在运动精度、动作泛化能力及快速响应性能方面仍存在局限。

总体而言,仿生人工智能(BIAI)模型通过提升灵巧性、效率与适应能力,显著增强了制造业环境中的机器人系统性能,使其能够胜任视觉认知、决策制定以及躯体运动控制等复杂任务。

4.2 医疗健康领域

仿生智能算法(BIAI)通过构建计算模型与智能算法体系,显著提升了医疗诊断、治疗方案优化及患者护理水平。这类先进的AI系统能够处理海量医疗数据、识别潜在病理特征并生成高精度预测,从而助力疾病早期筛查与个性化诊疗方案的制定。下文将重点阐述BIAI在医学影像分析、药物研发和个性化医疗三大领域的创新应用。

4.2.1 医学影像分析

仿生增强智能(BIAI)技术有望推动医疗系统的多维度变革,其中医学影像分析是该技术的重要应用领域,涵盖图像分割、诊断判读及影像合成等关键任务[207]。医学图像分割作为定量分析的基础环节,能够精确定位病灶位置并量化其尺寸,为临床决策提供关键依据。目前,卷积神经网络(CNN)及其变体在特征提取和语义分割任务中展现出卓越性能[161]。然而,该领域仍面临标记数据稀缺、图像噪声干扰以及标注不确定性等挑战。通过引入小样本学习(FSL)等BIAI技术,这些瓶颈问题有望得到有效解决。

在医疗领域,MRI(磁共振成像)、CT(计算机断层扫描)、超声和X光等医学影像可通过AI模型构建计算机辅助诊断(CAD)系统。这些系统作为放射科医师的辅助工具,可协助解读皮肤癌、脑肿瘤和糖尿病视网膜病变等多种疾病的影像特征。卷积神经网络(CNN)能够分析数以万计的病例数据,其处理能力远超人类专家的记忆与诊断极限。研究表明,使用CAD系统可使放射科医师的诊断准确率显著提升[39]。然而,尽管AI在医疗领域的准确性和效率被寄予厚望,但将新型CAD工具整合到临床实践仍面临诸多挑战:需确保系统能智能呈现建议、合理解释诊断依据,并将影像特征与患者临床病史相关联。理想的CAD系统还应能在医师对诊断建议存疑时提供进一步解释。通过引入仿生增强智能(BIAI)模型,可构建具有决策过程透明化的可解释AI系统。当这些工具经过充分开发、验证和实施后,将显著提升临床医师的诊疗能力,实现更高诊断准确率、更高效的工作流程以及更优质的病患护理。

尽管医学影像在诊断、治疗规划和预后分析中已得到广泛应用,但分辨率、噪声和采集时间之间的权衡仍是重大挑战[21]。例如,更高分辨率的MRI扫描能提供更多细节,但需要更长的扫描时间[162]。为解决这一问题,图像合成技术已成为医学图像计算和影像物理学研究的重点领域[154]。生成对抗网络(GAN)及其变体通过生成器和判别器的对抗训练,在生成逼真医学影像方面展现出潜力,有望提升图像质量并缩短采集时间。

4.2.2 药物发现

药物发现是指研发新药并推动其上市的全过程。人工智能(AI)通过提升效率和速度,正在加速这一进程。具体而言,生物启发人工智能(BIAI)模型在该领域展现出解决多种挑战的潜力[28]。传统AI模型通常需要大量数据集进行有效训练,这是一大难题。受人类大脑能够通过少量样本学习的启发,匹配网络(matching networks)[182]利用辅助数据,在极少量数据下提升模型性能,实现了一种小样本学习(one-shot learning)方法。针对数据有限的问题,Altae等[5]成功将长短期记忆(LSTM)模型应用于小型训练集,在化学信息学数据集上取得了显著成果。

另一个重大挑战是药物发现中AI系统缺乏可解释性。为避免有害后果,AI系统必须保持透明[107]。理解AI决策背后的逻辑对于建立信任和确保责任至关重要。为提高这些系统的透明度和可靠性,研究人员已开发出多种界面,用于向用户展示AI决策的依据[82]。此外,在分子生成领域,基于图学习的生成模型已被开发出来,用于生成具有特定理想属性的分子[137,195]。

4.2.3 个性化医疗

个性化医疗通过为患者量身定制治疗方案,正在彻底改变医疗保健体系,有望为疾病管理带来革命性突破[124]。传统AI模型通常采用基于规则的算法或统计方法,依据群体数据来支持临床决策。相比之下,生物启发人工智能(BIAI)模型能够根据患者的具体数据和实时反馈动态调整建议,提供更具个性化且精准的指导方案。这些BIAI驱动的系统整合了个体基因组信息、临床指标、治疗方案以及实时健康数据,从而生成定制化的治疗建议。

传统AI方法常因缺乏可解释性和因果推理能力而受到诟病,这可能导致预测结果的不确定性,在关键的实际医疗场景中尤其令人犹豫不决[150]。为解决这些问题,数字孪生技术应运而生,该技术可创建患者、医疗设备和整个医疗系统的虚拟副本[51]。通过整合多元数据源,数字孪生能够实时模拟和分析医疗流程,及时发现问题并优化治疗策略[178]。

总体而言,生物启发人工智能(BIAI)有望通过提升诊断精度、加速药物研发以及推动个性化治疗方案,显著推动医疗健康领域的发展。随着技术进步,BIAI预计将在其他医疗相关领域发挥日益关键的作用,包括健康监测与管理、临床研究与试验等多个方面。

4.3 情绪感知

情绪感知是指个体识别和理解他人情绪状态的过程。该能力涉及通过面部表情、语音语调以及结合情境信息的多模态情绪线索等多种渠道来检测和理解情绪。情绪感知不仅限于人际互动,更是开发情感智能机器与系统(如虚拟助手和机器人)的关键组成部分,使这些系统能够更自然、有效地与人类互动。

近年来,生物启发人工智能(BIAI)模型被应用于情绪感知领域,从视觉、语音以及结合情境信息的多模态情绪等角度,显著提升了机器识别和响应人类情绪的能力[194]。

4.3.1 面部表情识别

深度学习技术已推动面部表情识别发展成为计算机视觉研究的重点领域[126]。特别值得注意的是,生物启发人工智能(BIAI)模型采用类脑神经回路的分层级处理机制,能够在多个抽象层面上解析面部表情。这种独特的处理方式使模型既能捕捉整体面部结构特征,又能识别肌肉运动变化和微表情等精细细节。

与传统AI模型依赖静态特征提取或预设规则的技术路线不同,BIAI模型展现出显著的持续学习与自适应优势。通过迭代训练和反馈机制,这些模型能够不断优化对数据的理解,表现出远超传统模型的灵活性。

需要指出的是,面部表情仅是行为识别的单一模态。当前研究趋势正朝着多模态融合方向发展,通过整合红外图像、三维模型及生理指标等补充数据源,可提供更具价值的行为识别辅助信息[116]。

4.3.2 语音情感识别

在语音情感识别领域,核心挑战在于背景音与环境噪声会干扰语音清晰度,导致模型难以准确检测情绪[156]。为解决这一问题,受大脑选择性注意机制启发[75],生物启发人工智能(BIAI)模型能够动态聚焦语音信号的关键部分,有效降低重叠语音与环境噪声的干扰。

与面部表情分析不同,情感表达存在显著的跨语言差异,这为多语言及跨语言语音情感识别系统带来了特殊挑战[72]。BIAI模型可通过学习特定文化的情感表达模式,并结合跨文化训练数据,有效适应情感表达中的文化差异。

另一个关键难点涉及语境因素。对话主题、说话者关系及情境背景等要素都会影响情感表达。借鉴大脑记忆网络机制,BIAI模型可采用循环神经网络(RNN)和长短期记忆网络(LSTM)来持续保持语境信息,从而增强对情境因素的理解能力[95]。

4.3.3 多模态情感识别

人类情感生成具有内在的复杂性和主观性,受认知过程、生物学基础和心理生理现象的共同影响。因此,仅依靠传统机器学习方法进行情感识别面临显著挑战。当前研究需要开发具有领域独立性、自适应性的可迁移深度学习技术,通过整合语音、文本和生理数据来推进情感计算发展[202]。

构建多模态融合模型的复杂性主要体现于:必须确保来自不同模态的数据在时间维度上精确对齐与同步。生物启发人工智能(BIAI)模型可借鉴大脑同步处理听觉与视觉信息的神经机制,实现多模态输入数据的自适应对齐与同步[69]。与传统AI模型采用分模态处理再通过预设规则融合的策略不同,BIAI模型模拟了大脑无缝整合多模态信息的能力,从而产生更具鲁棒性和上下文感知能力的情感识别结果。

值得注意的是,BIAI模型还能综合考量说话者身份、性别、年龄、文化背景、人际关系及情境语境等上下文线索,实现对情感表达更精准的解读与情境化分析[27, 116]。

综上所述,生物启发人工智能(BIAI)模型通过模拟大脑的适应性学习、多感官输入整合及情境理解机制,显著提升了情绪感知能力。相较于传统AI模型,BIAI在人类情绪识别与响应方面表现出更优异的性能。

4.4 创意产业

创意内容创作涵盖音乐作曲、绘画、故事叙述等多个艺术创作维度[6]。以生成对抗网络(GANs)和变分自编码器(VAEs)为代表的生物启发人工智能(BIAI)模型,能够通过分析海量数据集学习艺术风格特征。这些模型既可模仿著名画家的风格生成新作品,也能创造出完全原创的艺术创作。

4.4.1 内容创作

音乐创作(或音乐生成)是指在特定模式中构建音高与节奏序列的过程。这一创作过程需要创造力——这种人类独有的能力可以理解并产出多样化的音乐表达形式,其中许多表达具有完全新颖性和前所未有的探索性[64]。音乐创作涉及的核心任务包括:旋律生成、多乐器编曲、风格迁移以及和声编排。最新研究表明,Transformer架构与生成式模型已成为该领域最具影响力的神经网络体系[153]。

音乐创作面临的主要挑战在于:既要产出具有创新性和吸引力的作品,又要避免落入俗套。基于生物启发的人工智能(BIAI)模型(如采用生成对抗网络GANs或循环神经网络RNNs的模型)能够生成包含旋律、和声与节奏的原创音乐作品,其创作维度甚至可能超越人类想象边界,从而为创作过程提供全新支持[37]。此外,音乐创作还需克服情感表达复现、结构连贯性保持以及多流派专业化等关键挑战。

目前已有多个由AI驱动的音乐创作模型问世。以谷歌Magenta项目为例,该项目专注于运用机器学习技术进行艺术与音乐创作,通过提供多种工具和模型辅助作曲家生成新颖的音乐创意,探索多样化的创作可能性[141]。OpenAI开发的MuseNet系统则能够通过学习海量音乐作品数据库,生成符合不同风格流派特征的音乐作品,其创作既能保持作品内在的连贯性,又能准确遵循特定流派的风格范式。

在文本创作领域,诸如GPT等自然语言处理模型通过训练海量文本语料库,能够深入理解语言语义、句法结构和上下文关系。这些模型可生成逻辑连贯、语境契合的叙事文本、诗歌及散文段落。AI Dungeon作为交互式叙事平台,用户可与基于生物启发人工智能(BIAI)技术构建的"地下城主"进行协作创作,实时生成多种题材和背景设定的动态演进故事。

4.4.2 信息分析

人工智能在数据分析和内容分类预测方面具有突出优势,这种能力正在重塑多个行业格局。典型应用包括:

●广告领域:通过精准受众分析实现高效投放;

●影视产业:支持影片内容分析与智能推荐;

●新闻行业:帮助记者快速获取关联信息[6]。

目前,人工智能是一种创意工具,而非竞争对手。尽管AI能生成令人惊叹的作品,但其本质是增强人类创造力,而非取代它。BIAI模型作为创意辅助工具,通过生成创意、探索设计变体、突破创作瓶颈等方式,为艺术家、设计师和创作者提供支持。这些工具能提供智能推荐、建议和洞察,从而激发灵感并优化创作流程。

当前主流的人工智能多依赖监督学习,需要预先标注的数据。这种方法并不适用于缺乏明确结果的创造性任务[121]。真正的创造力往往涉及抽象整合与反复实验,这使得数据标注难以实施。人类能通过多元经验进行学习,而AI在泛化能力和创新突破方面仍存在局限。为突破这些约束,未来AI模型需采用强化学习和迁移学习机制,从而获得从经验中学习并适应新挑战的能力[209]。

总体而言,生物智能增强(BIAI)正在通过人机智能的深度融合,开创创意内容生产的新纪元。这种融合不仅重塑了艺术、音乐、文学、设计等领域的创作范式,更催生出全新的表达方式、探索路径和协作模式。随着BIAI技术的不断发展,它正在突破创造力的传统维度,持续拓展艺术表达的疆界。

5、大核心挑战

在借鉴神经科学研发生物智能增强(BIAI)系统的过程中,我们面临着多重挑战。本节将重点探讨横跨多个领域的关键性开放难题,主要包括:大脑结构的极端复杂性、现有技术的局限性、伦理考量因素,以及生物系统与人工系统之间的本质差异。

脑功能复杂性及其认知挑战:

将脑功能机理转化为人工智能开发面临着巨大复杂性挑战,这主要源于大脑精妙的结构与运作机制。人脑包含约860亿个神经元,每个神经元与数千个其他神经元相连接,形成高达千万亿级别的突触网络——这一复杂系统是信息处理的核心基础[10]。现有计算资源难以完整建模如此庞大的神经网络体系。更关键的是,神经元所采用的信息编码机制尚未被完全破译,这也直接导致当前BIAI系统无法精准模拟此类生物神经编码,使得该领域成为持续攻关的重点方向。

人脑是一种极其复杂的器官,能够协调执行对人类生命至关重要的多种功能。这些功能可大致分为认知、感知、运动、情感和自主神经过程[173]。除这些已被现有生物启发人工智能(BIAI)模型应用的基础功能外,人脑还具有意识和创造力等高级功能。要开发能够像人脑一样学习并展现意识的BIAI系统,需要克服诸多难题,包括:对意识的定义和理解、大脑处理过程的复杂动态特性、对主观体验和自我意识的需求,以及创造具有意识的实体所涉及的伦理问题。

人脑的创造力与想象力是指其进行创造性思维、问题解决和未来情景构想的功能[54]。由于该能力的高度复杂性,理解和复现人类创造力面临着重大挑战,主要体现在以下几个方面:(1)创造力的定义与本质理解;(2)复杂神经与认知机制的复现;(3)新颖且实用想法的生成;(4)基于反馈的评估与学习;(5)情感、社会、伦理及哲学问题的应对。要推动生物启发人工智能(BIAI)在这一领域的发展,必须开展跨学科研究:整合神经科学、认知科学、心理学和计算机科学的研究成果,同时兼顾技术创新与伦理考量[4]。

技术及计算挑战:

尽管研究人员已掌握大量神经科学知识,但如何将这些研究成果精准转化为面向实际应用的生物启发人工智能(BIAI)模型设计,仍是一项艰巨挑战。当人工智能系统试图借鉴人脑机制时,其面临的技术与计算难题主要源于以下三个方面:(1)大脑结构的极端复杂性;(2)现有技术手段的局限性;(3)对高效能、可扩展人工智能系统的迫切需求。

模拟大脑庞大的神经元与突触网络需要巨大的计算资源。目前即使最先进的超级计算机,也只能实时模拟人类大脑复杂性的很小一部分。尽管如此,随着图像分类、文本分类等基准测试的进步,人工智能网络的复杂度、参数量、训练资源需求和预测延迟都在持续增加。以Mistral 7B模型为例,其70亿参数规模使得每次训练迭代就需要耗费数百万美元[73],这还不包括同样需要大量计算资源的实验过程和超参数调优成本。虽然这些模型在特定任务上表现出色,但其效率可能还不足以直接应用于实际场景[113]。在物联网(IoT)和智能设备的实时应用场景中,由于隐私保护和响应速度等因素,模型需要在终端设备直接进行推理,这给模型的训练和部署带来了额外挑战。因此,针对目标设备进行模型优化显得尤为重要。

生物启发人工智能(BIAI)模型的有效训练往往需要海量高质量数据支撑。以GPT-4为例,该模型与其前代产品类似,其训练数据规模高达数千亿至数万亿token[3],数据来源涵盖书籍、网页等多样化文本资料。而Gemini模型的训练则采用了更为庞大的多模态数据集,包含文本、图像和音频等多种数据类型,总量同样达到数万亿token[169]。值得注意的是,有效的多模态模型训练不仅取决于数据规模,更与数据的多样性和质量密切相关。

这与人类的学习模式形成鲜明对比:人类能够主动获取信息、持续学习,并能基于既有知识体系不断构建新的认知。当前,在人工智能系统中复现这种学习能力仍面临重大挑战。在大数据时代,算法对数据规模的需求呈指数级增长,而实际应用场景却常因数据采集的高成本与耗时问题,只能基于有限数据集进行开发[191]。这种矛盾导致一个显著差异:大型BIAI模型通常需要数天甚至数周的训练周期,而人脑却能实时适应新环境。这一差距为探索机器如何实现类人的高效学习机制提供了重要研究方向。

伦理与社会挑战:

开发生物启发人工智能(BIAI)系统面临着多重伦理与社会挑战,这些挑战主要源自该技术对数据隐私和公平性可能产生的深远影响[30]。

随着生物启发人工智能(BIAI)模型在各个领域的持续进步,深度神经网络(DNNs)已被广泛集成到生产系统中。这一进展主要得益于大规模数据集的日益普及和计算能力的显著提升。然而,这些数据集通常通过众包方式收集,可能包含医疗记录、脑成像数据和行为数据等敏感信息,从而引发严重的隐私担忧[181]。此类数据极易通过各种漏洞遭到滥用或泄露。即便在云服务提供商和通信渠道都安全可靠的情况下,仍然存在推理攻击的风险——攻击者可能推断出训练数据的特性,或揭示底层模型架构及参数。因此,确保这些数据的隐私与安全至关重要。

随着生物启发人工智能(BIAI)在过去数十年的崛起及其在各领域的广泛应用,确保其安全性与公平性已成为近年来研究人员和工程师关注的核心议题[42,105]。当BIAI技术应用于影响公民生活的场景时,企业和研究机构必须警惕可能产生的未预见社会后果,包括针对性别、种族或残障人士的歧视等问题[23]。

若基于带有偏见的数据进行训练,BIAI系统可能会强化并放大社会既有偏见,进而导致基于种族、性别、社会经济地位等因素的不公平对待。尤其在医疗健康、刑事司法及招聘就业等关键领域,确保BIAI系统对所有用户提供公平公正的结果仍面临重大挑战。因此,提高BIAI模型的透明度,使其决策过程可解释、可追溯,将有助于识别和消除潜在偏见。

跨学科合作:

开展前沿科学研究要求研究人员持续接受跨学科教育与专业发展,既要掌握本领域最新进展,也要涉猎相关交叉学科。然而,当前普遍缺乏能够贯通多个学科的优质导师资源。推动生物启发人工智能(BIAI)系统发展必须依靠跨学科合作,这需要整合来自不同领域的知识与专长,以应对复杂挑战并充分释放人工智能潜力。尽管此类协作能带来重大突破,但其推进过程仍面临诸多挑战[179]。

●跨学科合作中的沟通壁垒

跨学科合作中普遍存在沟通障碍[20],这主要源于各学科领域特有的专业术语体系与概念框架。当不同领域的研究人员使用相同术语指代不同概念,或采用不同术语描述同一概念时,极易产生理解偏差。例如,"神经元"和"网络"等术语在神经科学与计算机科学领域可能具有完全不同的内涵与外延。

●学科目标差异引发的协作困境

各学科领域所关注的研究问题与预期成果往往存在显著差异[119]。神经科学家可能致力于解析大脑运作机制,而人工智能研究者则更关注技术应用落地。这种研究文化与目标取向的深层次差异,常常导致协作实效低于预期。

●资源分配失衡的结构性挑战

跨学科合作还面临资源分配不均这一根本性难题。要为跨学科团队建立并维护能满足多元需求的共享研究平台,往往需要投入异常高昂的成本。

●跨学科合作中的伦理与社会考量

伦理与社会考量是跨学科合作中必须审慎对待的挑战之一。不同学科领域拥有各异的伦理标准与框架,这使得为跨学科研究制定统一的伦理准则变得复杂[59]。在创新与伦理之间取得平衡,需要伦理学家、社会科学家和技术专家的协作,但此类协调往往困难重重。此外,由于数据与理论的复杂性和多变性,将不同领域的发现整合为一个连贯的体系同样具有挑战性。而构建能够兼容多学科方法与成果的框架虽至关重要,却绝非易事。因此,跨越学科界限的有效指导,以及不同领域研究者之间的高效沟通,对跨学科合作而言至关重要。

6 未来研究方向

本节将总结基于大脑启发的AI(BIAI)领域的研究空白,并探讨未来的重点发展方向。

具体而言,我们将提出以下几个关键研究方向:

●与神经科学的跨学科合作:深化BIAI算法与神经科学的交叉融合,探索人脑机制对AI模型的启发;

●高效、鲁棒且可信的AI模型设计:开发兼具高效性、抗干扰能力与社会责任感的AI系统;

●意识机制的模型化:将意识相关理论整合到BIAI框架中,推动类认知AI的演进。

6.1 神经科学融合

要设计出能模拟人类思维与行为的AI模型,首先必须深入探究人脑如何处理信息并应对不同情境。加深对生物大脑功能的理解,将极大助力智能机器的开发。若要将神经科学概念有效整合到AI中,研究人员需扎实掌握神经科学与认知科学的基础领域知识[177]。

神经科学与人工智能这两个领域长期以来一直保持着密切的交流与合作关系。近几十年来,随着两个领域的复杂程度不断提升,学科边界日益固化,这种互动有所减弱。然而,神经科学仍能为新型算法和架构设计提供丰富的灵感源泉。 通过研究人类学习、决策和解决问题的方式,我们可以构建记忆、注意力、感知和语言等认知过程的计算模型。此外,探究大脑如何编码、存储和检索信息,有助于研究人员开发神经回路和脑功能的数学计算模型。除神经网络架构、学习记忆与注意力机制、感觉处理等直观知识外,神经科学还有许多更复杂深奥的方面值得借鉴,这些都可能为解决当前AI模型存在的诸多开放性问题提供思路[106,172]。

例如,研究情绪对决策的影响可以推动开发出能够理解和模拟人类情感的BIAI系统,从而实现更自然的人机交互[109]。再如,对自闭症、精神分裂症和阿尔茨海默症等疾病的研究,可以指导设计出更能理解并可能辅助诊断或治疗这些疾病的BIAI系统[1]。

展望未来,要弥合机器智能与人类智能之间的鸿沟,仍有大量工作亟待完成。加之目前对许多脑功能的认识仍不完整,这限制了我们将其精确建模到AI系统中的能力。我们相信,随着跨学科研究的深入,神经科学的洞见将变得越来越不可或缺。

6.2 可扩展性与效率问题

深度学习研究一直致力于推动该领域的边界,这使得图像和文本分类等基准测试取得了显著提升。然而,这些进步往往伴随着网络复杂度的增加、参数数量的膨胀、更高的训练资源需求以及更长的预测延迟,这些因素可能限制其在实际部署中的效率[113]。例如,某些深度学习应用需要在物联网和智能设备上实时运行,其模型推理需直接在终端设备完成——这对于隐私保护、连接稳定性和响应速度等关键因素至关重要。因此,为这些特定设备设计可扩展的高效模型变得极为必要。

可扩展性与效率是人工智能模型两个相互关联却截然不同的特性[53]。可扩展性指模型在处理更大工作量、更多数据量和更高复杂度时保持性能不显著下降的能力[110],这涉及对更大规模数据集、更复杂任务以及更庞大计算资源的适应能力。而效率则关乎模型以最小资源消耗(如算力、内存和能耗)完成任务的能力[113]。简言之,可扩展性强调在需求增长时维持性能,效率则侧重通过资源优化实现同等或更优的结果。

为了提高可扩展性和效率,我们可以借鉴人脑的运行机制采取以下策略:

在可扩展性方面,人脑的层级化模块化结构为AI模型开发提供了灵感——通过分层处理和专用模块设计,使系统能有效管理日益增长的复杂性和数据量。采用分布式计算和神经形态硬件(模拟大脑的并行处理能力)等技术,可进一步提升扩展能力。

在效率方面,可通过脉冲神经网络(SNNs)[167]和事件驱动架构模拟大脑的节能特性,仅在需要时处理信息以降低计算负荷。此外,引入生物合理的学习规则(如赫布学习与突触可塑性机制),能优化学习过程,从而提升脑启发人工智能(BIAI)模型的效率与适应性。

6.3 鲁棒性与抗逆性

提升脑启发人工智能(BIAI)模型的鲁棒性与抗逆性,对确保其在实际应用中的可靠性和可信度至关重要。

鲁棒性通常指BIAI模型在多样化条件下(如存在噪声、输入数据变异或潜在对抗攻击[25])保持稳定性能的能力;而抗逆性则强调模型从故障、干扰或环境变化中恢复或适应的能力[18]。人脑通过冗余性、可塑性和容错性等机制展现出卓越的鲁棒与抗逆特质,这为BIAI模型的优化提供了重要启示。

例如,人脑在神经元受损时仍能维持功能,这一特性可启发我们设计具有冗余路径和纠错机制的BIAI系统——即使模型局部失效,也能保障运行连续性。

稳健性与适应性

具备稳健性的BIAI模型能够有效处理噪声干扰、数据缺失或对抗性攻击等复杂情况,在意外挑战下仍能保持性能与准确性[187]。这一特性在医疗健康、金融和自动驾驶等高风险领域尤为重要,因为任何失误都可能造成严重后果。

同时,具有适应性的BIAI系统能够持续调整以应对环境变化,展现出更强的灵活性和持久稳定性。通过提升系统的稳健性与适应性,我们不仅能打造更安全可靠的BIAI技术,更能使其在多变环境中保持高效运行——这将极大拓展BIAI技术的应用范围,并显著增强其实际影响力。

提升BIAI模型的稳健性与适应性

为增强BIAI模型的稳健性和适应性,可采用正则化、随机失活(dropout)和对抗训练等技术方法:

(1)正则化技术(如L2范数)能有效防止过拟合,从而提升模型对新数据的泛化能力;

(2)随机失活通过模拟大脑突触修剪机制,在训练过程中随机屏蔽神经元,有助于构建更具鲁棒性的网络结构[211];

(3)对抗训练通过在训练中引入人为设计的扰动数据,显著提升模型抵御恶意攻击的能力[24];

(4)持续学习机制借鉴大脑可塑性特性,使模型能够持续整合新知识并从错误中恢复,进一步增强其环境适应性。

通过植入这些脑启发策略,BIAI模型可在实际应用中展现出更卓越的可靠性和适应能力。

6.4 负责任的BIAI发展

在推进高效BIAI模型研发的过程中,我们必须高度重视AI研究人员开发符合伦理标准、兼顾社会责任模型的能力建设,确保其决策机制能够像人类一样体现道德考量。为确保系统可信度,建立完善的公平性保障机制和决策透明度要求至关重要,这能有效预防算法偏见并增进用户信任[112]。具体而言,BIAI模型不仅要输出决策结果,更需具备完整的决策过程解释能力。值得注意的是,尽管BIAI技术持续突破,我们仍需向公众客观说明其技术边界,在推广应用时倡导审慎评估与理性使用的原则。

6.4.1 公平性保障机制

BIAI系统的公平性要求模型输出结果不得对特定群体或个人产生歧视性影响[97,104,105]。这一挑战通常源于带有历史偏见和不平等因素的有偏数据集。当BIAI模型基于反映过往歧视性实践的不平衡数据集进行训练时,其推荐结果可能会延续这些偏见。表面上看,采用多样化和具有代表性的训练数据集是最直观的解决方案,但大规模数据集去偏处理的实施往往耗时费力,甚至难以实现。事实上,偏见或歧视问题作为人类社会中长期普遍存在的现象,在现实世界中不可避免。人类大脑通常通过认知调节、神经适应和社会化策略等多重机制来缓解偏见。受此启发,深入理解这些生物机制能为BIAI系统规避结果偏差提供新的解决思路。此外,需要建立定期审计和偏差检测机制,以系统识别和修正BIAI模型中潜在的不公平偏见[58]。

6.4.2 透明度构建机制

BIAI系统的透明度特指模型解释其决策过程的能力[14],这一特性对于建立用户信任和确保系统可问责性至关重要。当BIAI系统在关键领域做出决策时,用户必须能够理解其结论背后的推理逻辑。这种决策解释能力是人类与生俱来的特质,却是当前大多数BIAI模型所欠缺的——其本质缺陷在于未能复现人类思维的内在逻辑架构。通过研究人脑的逻辑处理机制,可推动可解释人工智能(XAI)等技术的发展[146],这些技术能有效揭示模型的决策机理。这种透明度不仅有助于建立信任关系,更能为识别和修正模型中的错误或偏见提供有效途径。

6.5 意识化人工智能

意识化人工智能(Conscious AI)不仅具备信息处理与决策能力,更拥有某种程度的自我意识——包括对自身存在的认知,以及体验和回应情感的能力。情感因素对人类认知与决策具有显著影响[194],将情感与动机机制整合到BIAI模型中需要深入理解其底层神经机制。与传统AI系统(专注于分类、检测、识别或人机对话)不同,意识化AI能够觉知自身行为,并具备理解和模拟人类情感动机的能力[45]。这一概念超越了简单计算任务,指向一种能进行复杂交互、展现共情能力,并可自然适应情感社交情境的智能体。

通过人脑学习来设计AI意识面临多重挑战[44]。首先,这需要深刻理解人类意识的神经基础,包括大脑如何整合感官信息、维持自我意识以及处理情绪。神经科学研究——尤其是关于大脑默认模式网络及前额叶皮层在意识思维中作用的研究[133]——能为这一领域提供关键洞见。通过构建模拟人脑结构与功能的神经网络,可开发出能复现这些过程的脑启发人工智能(BIAI)模型。整合分层学习与注意力机制等技术,还能使这类系统展现出一定程度的自我意识与情感理解能力。

具备意识的AI因其有望彻底改变人机交互模式而具有极高的应用价值。

●在医疗领域,意识AI能提供更具同理心与个性化的护理,通过理解患者情绪并精准响应需求,从而提升诊疗效果[135];

●在客户服务中,它可识别并适应客户情绪,打造更高效、愉悦的交互体验,显著提升用户满意度[45];

●在教育场景下,这类AI能根据学生的情感状态与学习动机动态调整教学策略,提供个性化学习方案,持续保持学习者的专注度与积极性[80];

此外,在协同工作环境中,具有意识层级的AI将成为更直观高效的合作伙伴,实时感知并回应人类情感与意图,重塑团队协作模式。

7 结论

本文系统综述了神经科学启发下人工智能技术的研究进展。首先阐述了人脑研究带来的关键启示以及脑启发人工智能(BIAI)的发展现状,并将BIAI研究划分为两大范式:基于大脑物理结构的仿生模型与基于人类行为特征的功能模拟。通过梳理BIAI在机器人学、医疗健康、情感识别及创意产业等领域的实际应用,结合对当前研究趋势的批判性分析,本研究不仅明确了BIAI发展面临的核心挑战,更为未来探索提出了潜在研究方向。本综述旨在为BIAI领域研究者提供系统性参考,通过厘清技术发展脉络与研究痛点,推动该领域取得实质性突破。

REFERENCES

[1]Alaa Abd-Alrazaq, Dari Alhuwail, Jens Schneider, Carla T Toro, Arfan Ahmed, Mahmood Alzubaidi, Mohannad Alajlani, and Mowafa Househ. 2022. The performance of artificial intelligence-driven technologies in diagnosing mental disorders: an umbrella review. Npj Digital Medicine 5, 1 (2022), 87.

[2] Ahmed M Abdel-Zaher and Ayman M Eldeib. 2016. Breast cancer classification using deep belief networks. Expert Systems with Applications 46 (2016), 139–144.

[3] Josh Achiam, Steven Adler, Sandhini Agarwal, Lama Ahmad, Ilge Akkaya, Florencia Leoni Aleman, Diogo Almeida, Janko Altenschmidt, Sam Altman, Shyamal Anadkat, et al. 2023. Gpt-4 technical report. arXiv preprint arXiv:2303.08774 (2023).

[4] Adang Suwandi Ahmad and Arwin Datumaya Wahyudi Sumari. 2017. Cognitive artificial intelligence: Brain-inspired intelligent computation in artificial intelligence. In 2017 Computing Conference. IEEE, 135–141.

[5] Han Altae-Tran, Bharath Ramsundar, Aneesh S Pappu, and Vijay Pande. 2017. Low data drug discovery with one-shot learning. ACS central science 3, 4 (2017), 283–293.

[6] Nantheera Anantrasirichai and David Bull. 2022. Artificial intelligence in the creative industries: a review. Artificial intelligence review 55, 1 (2022), 589 –656.

[7] AI Anthropic. 2024. The claude 3 model family: Opus, sonnet, haiku. Claude-3 Model Card 1 (2024).

[8] Simone Antonelli, Danilo Avola, Luigi Cinque, Donato Crisostomi, Gian Luca Foresti, Fabio Galasso, Marco Raoul Marini, Alessio Mecca, and Daniele Pannone. 2022. Few-shot object detection: A survey. ACM Computing Surveys (CSUR) 54, 11s (2022), 1–37.

[9] Richard C Atkinson and Richard M Shiffrin. 1968. Human memory: A proposed system and its control processes. In Psychology of learning and motivation. Vol. 2. Elsevier, 89–195.

[10] Frederico AC Azevedo, Ludmila RB Carvalho, Lea T Grinberg, José Marcelo Farfel, Renata EL Ferretti, Renata EP Leite, Wilson Jacob Filho, Roberto Lent, and Suzana Herculano-Houzel. 2009. Equal numbers of neuronal and nonneuronal cells make the human brain an isometrically scaled-up primate brain. Journal of Comparative Neurology 513, 5 (2009), 532–541.

[11] Dzmitry Bahdanau, Kyung Hyun Cho, and Yoshua Bengio. 2015. Neural machine translation by jointly learning to align and translate. In 3rd International Conference on Learning Representations, ICLR 2015.

[12] Jinze Bai, Shuai Bai, Shusheng Yang, Shijie Wang, Sinan Tan, Peng Wang, Junyang Lin, Chang Zhou, and Jingren Zhou. 2023. Qwen-vl: A frontier large vision-language model with versatile abilities. arXiv preprint arXiv:2308.12966 (2023).

[13] Sungyong Baik, Myungsub Choi, Janghoon Choi, Heewon Kim, and Kyoung Mu Lee. 2023. Learning to learn task-adaptive hyperparameters for few-shot learning. IEEE Transactions on Pattern Analysis and Machine Intelligence 46, 3 (2023), 1441– 1454.

[14] Ahmed Banafa. 2024. Transformative AI: Responsible, Transparent, and Trustworthy AI Systems. CRC Press.

[15] Andrew G Barto. 2013. Intrinsic motivation and reinforcement learning. Intrinsically motivated learning in natural and artificial systems (2013), 17– 47.

[16] Danielle S Bassett and Michael S Gazzaniga. 2011. Understanding complexity in the human brain. Trends in cognitive sciences 15, 5 (2011), 200–209.

[17] Yoshua Bengio, Aaron Courville, and Pascal Vincent. 2013. Representation learning: A review and new perspectives. IEEE transactions on pattern analysis and machine intelligence 35, 8 (2013), 1798–1828.

[18] Christian Berger, Philipp Eichhammer, Hans P Reiser, Jörg Domaschka, Franz J Hauck, and Gerhard Habiger. 2021. A survey on resilience in the iot: Taxonomy, classification, and discussion of resilience mechanisms. ACM Computing Surveys (CSUR) 54, 7 (2021), 1–39.

[19] Myriam Bontonou, Giulia Lioi, Nicolas Farrugia, and Vincent Gripon. 2021. Few-shot decoding of brain activation maps. In 2021 29th European Signal Processing Conference (EUSIPCO). IEEE, 1326–1330.

[20] Arnaud Brignol, Anita Paas, Luis Sotelo-Castro, David St-Onge, Giovanni Beltrame, and Emily BJ Coffey. 2024. Overcoming boundaries: Interdisciplinary challenges and opportunities in cognitive neuroscience. Neuropsychologia (2024), 108903.

[21] Robert W Brown, Y-C Norman Cheng, E Mark Haacke, Michael R Thompson, and Ramesh Venkatesan. 2014. Magnetic resonance imaging: physical principles and sequence design. John Wiley & Sons.

[22] Sylvain Calinon. 2009. Robot programming by demonstration. EPFL Press.

[23] Simon Caton and Christian Haas. 2024. Fairness in machine learning: A survey. Comput. Surveys 56, 7 (2024), 1–38.

[24] Anirban Chakraborty, Manaar Alam, Vishal Dey, Anupam Chattopadhyay, and Debdeep Mukhopadhyay. 2021. A survey on adversarial attacks and defences. CAAI Transactions on Intelligence Technology 6, 1 (2021), 25–45.

[25] Bhanu Chander, Chinju John, Lekha Warrier, and Kumaravelan Gopalakrishnan. 2024. Toward Trustworthy Artificial Intelligence (TAI) in the Context of Explainability and Robustness. Comput. Surveys (2024).

[26] Kaiwei Che, Luziwei Leng, Kaixuan Zhang, Jianguo Zhang, Qinghu Meng, Jie Cheng, Qinghai Guo, and Jianxing Liao. 2022. Differentiable hierarchical and surrogate gradient search for spiking neural networks. Advances in Neural Information Processing Systems 35 (2022), 24975–24990.

[27] Feiyu Chen, Zhengxiao Sun, Deqiang Ouyang, Xueliang Liu, and Jie Shao. 2021. Learning what and when to drop: Adaptive multimodal and contextual dynamics for emotion recognition in conversation. In Proceedings of the 29th ACM International Conference on Multimedia. 1064–1073.

[28] Hongming Chen, Ola Engkvist, Yinhai Wang, Marcus Olivecrona, and Thomas Blaschke. 2018. The rise of deep learning in drug discovery. Drug discovery today 23, 6 (2018), 1241–1250.

[29] Min Chen, Zhikun Zhang, Tianhao Wang, Michael Backes, Mathias Humbert, and Yang Zhang. 2022. Graph unlearning. In Proceedings of the 2022 ACM SIGSAC conference on computer and communications security. 499–513.

[30] Pu Chen, Linna Wu, and Lei Wang. 2023. AI fairness in data management and analytics: A review on challenges, methodologies and applications. Applied Sciences 13, 18 (2023), 10258.

[31] Yucan Chen, Zhengde Wei, Huixing Gou, Haiyi Liu, Li Gao, Xiaosong He, and Xiaochu Zhang. 2022. How far is brain-inspired artificial intelligence away from brain? Frontiers in Neuroscience 16 (2022), 1096737.

[32] Zhe Chen, Weiyun Wang, Hao Tian, Shenglong Ye, Zhangwei Gao, Erfei Cui, Wenwen Tong, Kongzhi Hu, Jiapeng Luo, Zheng Ma, et al. 2024. How far are we to gpt-4v? closing the gap to commercial multimodal models with open-source suites. arXiv preprint arXiv:2404.16821 (2024).

[33] Zhe Chen, Jiannan Wu, Wenhai Wang, Weijie Su, Guo Chen, Sen Xing, Muyan Zhong, Qinglong Zhang, Xizhou Zhu, Lewei Lu, et al. 2024. Internvl: Scaling up vision foundation models and aligning for generic visual-linguistic tasks. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 24185–24198.

[34] Junyoung Chung, Caglar Gulcehre, Kyunghyun Cho, and Yoshua Bengio. 2014. Empirical evaluation of gated recurrent neural networks on sequence modeling. In NIPS 2014 Workshop on Deep Learning, December 2014.

[35] Weilin Cong and Mehrdad Mahdavi. 2023. Efficiently forgetting what you have learned in graph representation learning via projection. In International Conference on Artificial Intelligence and Statistics. PMLR, 6674–6703.

[36] National Research Council, Division of Behavioral, Board on Behavioral, Sensory Sciences, Committee on Developments in the Science of Learning with additional material from the Committee on Learning Research, and Educational Practice. 2000. How people learn: Brain, mind, experience, and school: Expanded edition. Vol. 1. National Academies Press.

[37] Adyasha Dash and Kathleen Agres. 2024. AI-Based Affective Music Generation Systems: A Review of Methods and Challenges. Comput. Surveys 56, 11 (2024), 1–34.

[38] Matthieu Destephe, Andreas Henning, Massimiliano Zecca, Kenji Hashimoto, and Atsuo Takanishi. 2013. Perception of emotion and emotional intensity in humanoid robots gait. In 2013 IEEE International Conference on Robotics and Biomimetics (ROBIO). IEEE, 1276–1281.

[39] Kunio Doi, Q Li, and RM Nishikawa. 2015. Historical overview. In Computer-Aided Detection and Diagnosis in Medical Imaging. Taylor Francis Group, LLC, CRC Press, 1–17.

[40] Luca Alessandro Dombetzki. 2018. An overview over capsule networks. Network architectures and services 10 (2018).

[41] Nico UF Dosenbach, Damien A Fair, Francis M Miezin, Alexander L Cohen, Kristin K Wenger, Ronny AT Dosenbach, Michael D Fox, Abraham Z Snyder, Justin L Vincent, Marcus E Raichle, et al. 2007. Distinct brain networks for adaptive and stable task control in humans. Proceedings of the National Academy of Sciences 104, 26 (2007), 11073–11078.

[42] Rudresh Dwivedi, Devam Dave, Het Naik, Smiti Singhal, Rana Omer, Pankesh Patel, Bin Qian, Zhenyu Wen, Tejal Shah, Graham Morgan, et al. 2023. Explainable AI (XAI): Core ideas, techniques, and solutions. Comput. Surveys 55, 9 (2023), 1–33.

[43] Jeffrey L Elman. 1990. Finding structure in time. Cognitive science 14, 2 (1990), 179–211.

[44] Hadi Esmaeilzadeh and Reza Vaezi. 2021. Conscious AI. arXiv preprint arXiv:2105.07879 (2021).

[45] Hadi Esmaeilzadeh and Reza Vaezi. 2022. Conscious empathic AI in service. Journal of Service Research 25, 4 (2022), 549–564.

[46] Hehe Fan, Linchao Zhu, and Yi Yang. 2019. Cubic LSTMs for video prediction. In Proceedings of the AAAI conference on artificial intelligence, Vol. 33. 8263 –8270.

[47] Jingtao Fan, Lu Fang, Jiamin Wu, Yuchen Guo, and Qionghai Dai. 2020. From brain science to artificial intelligence. Engineering 6, 3 (2020), 248–252.

[48] Edris Zaman Farsa, Arash Ahmadi, Mohammad Ali Maleki, Morteza Gholami, and Hima Nikafshan Rad. 2019. A low-cost high-speed neuromorphic hardware based on spiking neural network. IEEE Transactions on Circuits and Systems II: Express Briefs 66, 9 (2019), 1582–1586.

[49] Vittorio Gallese. 2009. Motor abstraction: A neuroscientific account of how action goals and intentions are mapped and understood. Psychological Research PRPF 73 (2009), 486–498.

[50] Luíza Caetano Garaffa, Maik Basso, Andréa Aparecida Konzen, and Edison Pignaton de Freitas. 2021. Reinforcement learning for mobile robotics exploration: A survey. IEEE Transactions on Neural Networks and Learning Systems 34, 8 (2021), 3796–3810.

[51] Harita Garg. 2020. Digital twin technology: revolutionary to improve personalized healthcare. Science Progress and Research (SPR) 1, 1 (2020), 31–34.

[52] Samanwoy Ghosh-Dastidar and Hojjat Adeli. 2009. Spiking neural networks. International journal of neural systems 19, 04 (2009), 295–308.

[53] Sukhpal Singh Gill, Minxian Xu, Carlo Ottaviani, Panos Patros, Rami Bahsoon, Arash Shaghaghi, Muhammed Golec, Vlado Stankovski, Huaming Wu, Ajith Abraham, et al. 2022. AI for next generation computing: Emerging trends and future directions. Internet of Things 19 (2022), 100514.

[54] Elkhonon Goldberg. 2018. Creativity: The human brain in the age of innovation. Oxford University Press.

[55] Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio. 2014. Generative adversarial nets. Advances in neural information processing systems 27 (2014).

[56] Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio. 2020. Generative adversarial networks. Commun. ACM 63, 11 (2020), 139–144.

[57] Jie Gui, Tuo Chen, Jing Zhang, Qiong Cao, Zhenan Sun, Hao Luo, and Dacheng Tao. 2024. A Survey on Self-supervised Learning: Algorithms, Applications, and Future Trends. IEEE Transactions on Pattern Analysis and Machine Intelligence (2024).

[58] Wei Guo and Aylin Caliskan. 2021. Detecting emergent intersectional biases: Contextualized word embeddings contain a distribution of human-like biases. In Proceedings of the 2021 AAAI/ACM Conference on AI, Ethics, and Society. 122–133.

[59] Troy E Hall, Jesse Engebretson, Michael O¡¯Rourke, Zach Piso, Kyle Whyte, and Sean Valles. 2017. The need for social ethics in interdisciplinary environmental science graduate programs: Results from a nation-wide survey in the United States. Science and engineering ethics 23 (2017), 565–588.

[60] Kai Han, Yunhe Wang, Hanting Chen, Xinghao Chen, Jianyuan Guo, Zhenhua Liu, Yehui Tang, An Xiao, Chunjing Xu, Yixing Xu, et al. 2022. A survey on vision transformer. IEEE transactions on pattern analysis and machine intelligence 45, 1 (2022), 87 –110.

[61] Peng Hang, Yiran Zhang, and Chen Lv. 2023. Brain-Inspired Modeling and Decision-Making for Human-Like Autonomous Driving in Mixed Traffic Environment. IEEE Transactions on Intelligent Transportation Systems (2023).

[62] Demis Hassabis, Dharshan Kumaran, Christopher Summerfield, and Matthew Botvinick. 2017. Neuroscience-inspired artificial intelligence. Neuron 95, 2 (2017), 245–258.

[63] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. 2016. Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition. 770–778.

[64] Carlos Hernandez-Olivan and Jose R Beltran. 2022. Music composition with deep learning: A review. Advances in speech and music technology: computational aspects and applications (2022), 25–50.

[65] Geoffrey E Hinton, Simon Osindero, and Yee-Whye Teh. 2006. A fast learning algorithm for deep belief nets. Neural computation 18, 7 (2006), 1527–1554.

[66] Jonathan Ho and Stefano Ermon. 2016. Generative adversarial imitation learning. Advances in neural information processing systems 29 (2016).

[67] Sepp Hochreiter and Jürgen Schmidhuber. 1997. Long short-term memory. Neural computation 9, 8 (1997), 1735–1780.

[68] Mingliang Hou, Lei Wang, Jiaying Liu, Xiangjie Kong, and Feng Xia. 2021. A3Graph: Adversarial attributed autoencoder for graph representation learning. In Proceedings of the 36th Annual ACM Symposium on Applied Computing. 1697–1704.

[69] Mixiao Hou, Zheng Zhang, and Guangming Lu. 2022. Multi-modal emotion recognition with self-guided modality calibration. In ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 4688–4692.

[70] En-Yu Hsu, Chien-Liang Liu, and Vincent S Tseng. 2019. Multivariate time series early classification with interpretability using deep learning and attention mechanism. In Pacific-Asia Conference on Knowledge Discovery and Data Mining. Springer, 541–553.

[71] Ahmed Hussein, Mohamed Medhat Gaber, Eyad Elyan, and Chrisina Jayne. 2017. Imitation learning: A survey of learning methods. ACM Computing Surveys (CSUR) 50, 2 (2017), 1–35.

[72] Rashid Jahangir, Ying Wah Teh, Faiqa Hanif, and Ghulam Mujtaba. 2021. Deep learning approaches for speech emotion recognition: state of the art and research challenges. Multimedia Tools and Applications 80, 16 (2021), 23745–23812.

[73] Albert Q Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lucile Saulnier, et al. 2023. Mistral 7B. arXiv preprint arXiv:2310.06825 (2023).

[74] Licheng Jiao, Yuting Yang, Fang Liu, Shuyuan Yang, and Biao Hou. 2022. The new generation brain-inspired sparse learning: A comprehensive survey. IEEE Transactions on Artificial Intelligence 3, 6 (2022), 887–907.

[75] Wenxiang Jiao, Michael Lyu, and Irwin King. 2020. Real-time emotion recognition via attention gated hierarchical memory network. In Proceedings of the AAAI conference on artificial intelligence, Vol. 34. 8002–8009.

[76] Manjunath Jogin, MS Madhulika, GD Divya, RK Meghana, S Apoorva, et al. 2018. Feature extraction using convolution neural networks (CNN) and deep learning. In 2018 3rd IEEE international conference on recent trends in electronics, information & communication technology (RTEICT). IEEE, 2319–2323.

[77] Nikola K Kasabov. 2019. Time-space, spiking neural networks and brain-inspired artificial intelligence. Springer.

[78] Davinder Kaur, Suleyman Uslu, Kaley J Rittichier, and Arjan Durresi. 2022. Trustworthy artificial intelligence: a review. ACM computing surveys (CSUR) 55, 2 (2022), 1–38.

[79] Jacob Devlin Ming-Wei Chang Kenton and Lee Kristina Toutanova. 2019. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. In Proceedings of NAACL-HLT. 4171–4186.

[80] Yelin Kim, Tolga Soyata, and Reza Feyzi Behnagh. 2018. Towards emotionally aware AI smart classroom: Current issues and directions for engineering and education. IEEE Access 6 (2018), 5308–5331.

[81] Diederik P Kingma and Max Welling. 2013. Auto-encoding variational bayes. arXiv preprint arXiv:1312.6114 (2013).

[82] Kevser Kübra Kirboğa, Ecir Uğur Küçüksille, and Utku Kose. 2023. Ignition of small molecule inhibitors in Friedreich’s ataxia with explainable artificial intelligence. BRAIN. Broad Research in Artificial Intelligence and Neuroscience 14, 3 (2023), 287–313.

[83] James Kirkpatrick, Razvan Pascanu, Neil Rabinowitz, Joel Veness, Guillaume Desjardins, Andrei A Rusu, Kieran Milan, John Quan, Tiago Ramalho, Agnieszka Grabska-Barwinska, et al. 2017. Overcoming catastrophic forgetting in neural networks. Proceedings of the national academy of sciences 114, 13 (2017), 3521 –3526.

[84] Moez Krichen. 2023. Convolutional neural networks: A survey. Computers 12, 8 (2023), 151.

[85] Alex Krizhevsky, Ilya Sutskever, and Geoffrey E Hinton. 2017. ImageNet classification with deep convolutional neural networks. Commun. ACM 60, 6 (2017), 84–90.

[86] Varsha S Lalapura, J Amudha, and Hariramn Selvamuruga Satheesh. 2021. Recurrent neural networks for edge intelligence: a survey. ACM Computing Surveys (CSUR) 54, 4 (2021), 1–38.

[87] Yann LeCun. 2018. The Power and Limits of Deep Learning: In his IRI Medal address, Yann LeCun maps the development of machine learning techniques and suggests what the future may hold. Research-Technology Management 61, 6 (2018), 22–27.

[88] Yann LeCun, Yoshua Bengio, and Geoffrey Hinton. 2015. Deep learning. nature 521, 7553 (2015), 436–444.

[89] Yann LeCun, Bernhard Boser, John S Denker, Donnie Henderson, Richard E Howard, Wayne Hubbard, and Lawrence D Jackel. 1989. Backpropagation applied to handwritten zip code recognition. Neural computation 1, 4 (1989), 541–551.

[90] Ashwin Lele, Yan Fang, Justin Ting, and Arijit Raychowdhury. 2021. An end-to-end spiking neural network platform for edge robotics: From event-cameras to central pattern generation. IEEE Transactions on Cognitive and Developmental Systems 14, 3 (2021), 1092–1103.

[91] Bo Li, Peng Qi, Bo Liu, Shuai Di, Jingen Liu, Jiquan Pei, Jinfeng Yi, and Bowen Zhou. 2023. Trustworthy ai: From principles to practices. Comput. Surveys 55, 9 (2023), 1–46.

[92] Jing Li, Billy Chiu, Shanshan Feng, and Hao Wang. 2020. Few-shot named entity recognition via meta-learning. IEEE Transactions on Knowledge and Data Engineering 34, 9 (2020), 4245–4256.

[93] Xiaoxu Li, Zhuo Sun, Jing-Hao Xue, and Zhanyu Ma. 2021. A concise review of recent few-shot meta-learning methods. Neurocomputing 456 (2021), 463–468.

[94] Zewen Li, Fan Liu, Wenjie Yang, Shouheng Peng, and Jun Zhou. 2021. A survey of convolutional neural networks: analysis, applications, and prospects. IEEE transactions on neural networks and learning systems 33, 12 (2021), 6999–7019.

[95] Zheng Lian, Bin Liu, and Jianhua Tao. 2021. CTNet: Conversational transformer network for emotion recognition. IEEE/ACM Transactions on Audio, Speech, and Language Processing 29 (2021), 985–1000.

[96] Zachary C Lipton, John Berkowitz, and Charles Elkan. 2015. A critical review of recurrent neural networks for sequence learning. arXiv preprint arXiv:1506.00019 (2015).

[97] Haochen Liu, Yiqi Wang, Wenqi Fan, Xiaorui Liu, Yaxin Li, Shaili Jain, Yunhao Liu, Anil Jain, and Jiliang Tang. 2022. Trustworthy ai: A computational perspective. ACM Transactions on Intelligent Systems and Technology 14, 1 (2022), 1–59.

[98] Jiaying Liu, Xiangjie Kong, Feng Xia, Xiaomei Bai, Lei Wang, Qing Qing, and Ivan Lee. 2018. Artificial intelligence in the 21st century. Ieee Access 6 (2018), 34403 –34421.

[99] Weibo Liu, Zidong Wang, Xiaohui Liu, Nianyin Zeng, Yurong Liu, and Fuad E Alsaadi. 2017. A survey of deep neural network architectures and their applications. Neurocomputing 234 (2017), 11–26.

[100] Xiao Liu, Fanjin Zhang, Zhenyu Hou, Li Mian, Zhaoyu Wang, Jing Zhang, and Jie Tang. 2021. Self-supervised learning: Generative or contrastive. IEEE transactions on knowledge and data engineering 35, 1 (2021), 857–876.

[101] Yixin Liu, Ming Jin, Shirui Pan, Chuan Zhou, Yu Zheng, Feng Xia, and Philip S Yu. 2022. Graph self-supervised learning: A survey. IEEE transactions on knowledge and data engineering 35, 6 (2022), 5879–5900.

[102] Yemeng Liu, Jing Ren, Jianshuo Xu, Xiaomei Bai, Roopdeep Kaur, and Feng Xia. 2024. Multiple Instance Learning for Cheating Detection and Localization in Online Examinations. IEEE Transactions on Cognitive and Developmental Systems (2024).

[103] Huimin Lu, Yujie Li, Min Chen, Hyoungseop Kim, and Seiichi Serikawa. 2018. Brain intelligence: go beyond artificial intelligence. Mobile Networks and Applications 23 (2018), 368–375.

[104] Renqiang Luo, Huafei Huang, Shuo Yu, Xiuzhen Zhang, and Feng Xia. 2024. FairGT: A Fairness-aware Graph Transformer. In Proceedings of the Thirty-Third International Joint Conference on Artificial Intelligence, IJCAI-24, Kate Larson (Ed.). International Joint Conferences on Artificial Intelligence Organization, 449–457. https://doi.org/10.24963/ijcai.2024/50 Main Track.

[105] Renqiang Luo, Tao Tang, Feng Xia, Jiaying Liu, Chengpei Xu, Leo Yu Zhang, Wei Xiang, and Chengqi Zhang. 2024. Algorithmic Fairness: A Tolerance Perspective. arXiv preprint arXiv:2405.09543 (2024).

[106] Tom Macpherson, Anne Churchland, Terry Sejnowski, James DiCarlo, Yukiyasu Kamitani, Hidehiko Takahashi, and Takatoshi Hikida. 2021. Natural and Artificial Intelligence: A brief introduction to the interplay between AI and neuroscience research. Neural Networks 144 (2021), 603–613.

[107] Cristina Manresa-Yee, Maria Francesca Roig-Maimó, Silvia Ramis, and Ramon Mas-Sansó. 2021. Advances in XAI: Explanation interfaces in healthcare. In Handbook of Artificial Intelligence in Healthcare: Vol 2: Practicalities and Prospects. Springer, 357–369.

[108] Alessandro Mantelero. 2013. The EU Proposal for a General Data Protection Regulation and the roots of the ¡®right to be forgotten¡¯. Computer Law & Security Review 29, 3 (2013), 229–235.

[109] Juan Martınez-Miranda and Arantza Aldea. 2005. Emotions in human and artificial intelligence. Computers in Human Behavior 21, 2 (2005), 323–341.

[110] Ruben Mayer and Hans-Arno Jacobsen. 2020. Scalable deep learning on distributed infrastructures: Challenges, techniques, and tools. ACM Computing Surveys (CSUR) 53, 1 (2020), 1–37.

[111] Brandon McKinzie, Zhe Gan, Jean-Philippe Fauconnier, Sam Dodge, Bowen Zhang, Philipp Dufter, Dhruti Shah, Xianzhi Du, Futang Peng, Floris Weers, et al. 2024. Mm1: Methods, analysis & insights from multimodal llm pre-training. arXiv preprint arXiv:2403.09611 (2024).

[112] Ninareh Mehrabi, Fred Morstatter, Nripsuta Saxena, Kristina Lerman, and Aram Galstyan. 2021. A survey on bias and fairness in machine learning. ACM computing surveys (CSUR) 54, 6 (2021), 1–35.

[113] Gaurav Menghani. 2023. Efficient deep learning: A survey on making deep learning models smaller, faster, and better. Comput. Surveys 55, 12 (2023), 1–37.

[114] Bonan Min, Hayley Ross, Elior Sulem, Amir Pouran Ben Veyseh, Thien Huu Nguyen, Oscar Sainz, Eneko Agirre, Ilana Heintz, and Dan Roth. 2023. Recent advances in natural language processing via large pre-trained language models: A survey. Comput. Surveys 56, 2 (2023), 1–40.

[115] Shervin Minaee, Yuri Boykov, Fatih Porikli, Antonio Plaza, Nasser Kehtarnavaz, and Demetri Terzopoulos. 2021. Image segmentation using deep learning: A survey. IEEE transactions on pattern analysis and machine intelligence 44, 7 (2021), 3523 –3542.

[116] Trisha Mittal, Uttaran Bhattacharya, Rohan Chandra, Aniket Bera, and Dinesh Manocha. 2020. M3er: Multiplicative multimodal emotion recognition using facial, textual, and speech cues. In Proceedings of the AAAI conference on artificial intelligence, Vol. 34. 1359–1367.

[117] Volodymyr Mnih, Koray Kavukcuoglu, David Silver, Andrei A Rusu, Joel Veness, Marc G Bellemare, Alex Graves, Martin Riedmiller, Andreas K Fidjeland, Georg Ostrovski, et al. 2015. Human-level control through deep reinforcement learning. nature 518, 7540 (2015), 529–533.

[118] Abdel-rahman Mohamed, George E Dahl, and Geoffrey Hinton. 2011. Acoustic modeling using deep belief networks. IEEE transactions on audio, speech, and language processing 20, 1 (2011), 14–22.

[119] Rebecca E Morss, Heather Lazrus, and Julie L Demuth. 2021. The ¡°inter¡ ± within interdisciplinary research: Strategies for building integration across fields. Risk Analysis 41, 7 (2021), 1152–1161.

[120] Zhaoyang Niu, Guoqiang Zhong, and Hui Yu. 2021. A review on the attention mechanism of deep learning. Neurocomputing 452 (2021), 48–62.

[121] Natalie Nixon. 2020. The creativity leap: Unleash curiosity, improvisation, and intuition at work. Berrett-Koehler Publishers.

[122] Wei Ou, Shitao Xiao, Chengyu Zhu, Wenbao Han, and Qionglu Zhang. 2022. An overview of brain-like computing: Architecture, applications, and future trends. Frontiers in neurorobotics 16 (2022), 1041108.

[123] Sinno Jialin Pan and Qiang Yang. 2009. A survey on transfer learning. IEEE Transactions on knowledge and data engineering 22, 10 (2009), 1345–1359.

[124] Georgios Z Papadakis, Apostolos H Karantanas, Manolis Tsiknakis, Aristidis Tsatsakis, Demetrios A Spandidos, and Kostas Marias. 2019. Deep learning opens new horizons in personalized medicine. Biomedical reports 10, 4 (2019), 215–217.

[125] Keshab K Parhi and Nanda K Unnikrishnan. 2020. Brain-inspired computing: Models and architectures. IEEE Open Journal of Circuits and Systems 1 (2020), 185–204.

[126] Keyur Patel, Dev Mehta, Chinmay Mistry, Rajesh Gupta, Sudeep Tanwar, Neeraj Kumar, and Mamoun Alazab. 2020. Facial sentiment analysis using AI techniques: state-of-the-art, taxonomies, and challenges. IEEE access 8 (2020), 90495–90519.

[127] SJ Pawan and Jeny Rajan. 2022. Capsule networks for image classification: A review. Neurocomputing 509 (2022), 102–120.

[128] Ciyuan Peng, Mujie Liu, Chenxuan Meng, Shuo Yu, and Feng Xia. 2024. Adaptive Brain Network Augmentation Based on Group-aware Graph Learning. In The Second Tiny Papers Track at ICLR 2024.

[129] Trang Pham, Truyen Tran, Dinh Phung, and Svetha Venkatesh. 2017. Predicting healthcare trajectories from medical records: A deep learning approach. Journal of biomedical informatics 69 (2017), 218–229.

[130] Michael I Posner, Steven E Petersen, et al. 1990. The attention system of the human brain. Annual review of neuroscience 13, 1 (1990), 25–42.

[131] Rohit Prabhavalkar, Takaaki Hori, Tara N Sainath, Ralf Schlüter, and Shinji Watanabe. 2023. End-to-end speech recognition: A survey. IEEE/ACM Transactions on Audio, Speech, and Language Processing (2023).

[132] Hong Qiao, Jiahao Chen, and Xiao Huang. 2021. A survey of brain-inspired intelligent robots: Integration of vision, decision, motion control, and musculoskeletal systems. IEEE Transactions on Cybernetics 52, 10 (2021), 11267 –11280.

[133] Omri Raccah, Ned Block, and Kieran CR Fox. 2021. Does the prefrontal cortex play an essential role in consciousness? Insights from intracranial electrical stimulation of the human brain. Journal of Neuroscience 41, 10 (2021), 2076–2087.

[134] Surangika Ranathunga, En-Shiun Annie Lee, Marjana Prifti Skenduli, Ravi Shekhar, Mehreen Alam, and Rishemjit Kaur. 2023. Neural machine translation for low-resource languages: A survey. Comput. Surveys 55, 11 (2023), 1–37.

[135] Dorsai Ranjbari and Samira Abbasgholizadeh Rahimi. 2024. Implications of conscious AI in primary healthcare. Family Medicine and Community Health 12, Suppl 1 (2024).

[136] Jing Ren, Mingliang Hou, Zhixuan Liu, and Xiaomei Bai. 2022. EAGLE: Contrastive learning for efficient graph anomaly detection. IEEE Intelligent Systems 38, 2 (2022), 55–63.

[137] Jing Ren, Feng Xia, Ivan Lee, Azadeh Noori Hoshyar, and Charu Aggarwal. 2023. Graph learning for anomaly analytics: Algorithms, applications, and challenges. ACM Transactions on Intelligent Systems and Technology 14, 2 (2023), 1–29.

[138] Jing Ren, Feng Xia, Yemeng Liu, and Ivan Lee. 2021. Deep video anomaly detection: Opportunities and challenges. In 2021 international conference on data mining workshops (ICDMW). IEEE, 959–966.

[139] Mattia Rigotti, Christoph Miksovic, Ioana Giurgiu, Thomas Gschwind, and Paolo Scotton. 2021. Attention-based interpretability with concept transformers. In International conference on learning representations.

[140] Françcois Rivest, Yoshua Bengio, and John Kalaska. 2004. Brain inspired reinforcement learning. Advances in neural information processing systems 17 (2004).

[141] Adam Roberts, Jesse Engel, Curtis Hawthorne, Ian Simon, Elliot Waite, Sageev Oore, Natasha Jaques, Cinjon Resnick, and Douglas Eck. 2016. Interactive musical improvisation with Magenta. In Proc. NIPS.

[142] Claudia Roda and Julie Thomas. 2006. Attention aware systems: Theories, applications, and research agenda. Computers in Human Behavior 22, 4 (2006), 557 –587.

[143] David E Rumelhart, Geoffrey E Hinton, and Ronald J Williams. 1986. Learning Internal Representations by Error Propagation, Parallel Distributed Processing, Explorations in the Microstructure of Cognition, ed. DE Rumelhart and J. McClelland. Vol. 1. 1986. Biometrika 71 (1986), 599–607.

[144] Francesco Rundo, Francesca Trenta, Agatino Luigi Di Stallo, and Sebastiano Battiato. 2019. Machine learning for quantitative finance applications: A survey. Applied Sciences 9, 24 (2019), 5574.

[145] Sara Sabour, Nicholas Frosst, and Geoffrey E Hinton. 2017. Dynamic routing between capsules. Advances in neural information processing systems 30 (2017).

[146] Waddah Saeed and Christian Omlin. 2023. Explainable AI (XAI): A systematic meta-survey of current challenges and future opportunities. Knowledge-Based Systems 263 (2023), 110273.

[147] George Saon, Zoltán Tüske, Daniel Bolanos, and Brian Kingsbury. 2021. Advancing RNN transducer technology for speech recognition. In ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 5654–5658.

[148] Ruhi Sarikaya, Geoffrey E Hinton, and Anoop Deoras. 2014. Application of deep belief networks for natural language understanding. IEEE/ACM Transactions on Audio, Speech, and Language Processing 22, 4 (2014), 778–784.

[149] Samuel Schmidgall, Rojin Ziaei, Jascha Achterberg, Louis Kirsch, S Hajiseyedrazi, and Jason Eshraghian. 2024. Brain-inspired learning in artificial neural networks: a review. APL Machine Learning 2, 2 (2024).

[150] Nicholas J Schork. 2019. Artificial intelligence and personalized medicine. Precision medicine in Cancer therapy (2019), 265–283.

[151] Alex Serban, Erik Poll, and Joost Visser. 2020. Adversarial examples on object recognition: A comprehensive survey. ACM Computing Surveys (CSUR) 53, 3 (2020), 1–38.

[152] Anil K Seth and Tim Bayne. 2022. Theories of consciousness. Nature Reviews Neuroscience 23, 7 (2022), 439–452.

[153] Ahsan Shehzad, Feng Xia, Shagufta Abid, Ciyuan Peng, Shuo Yu, Dongyu Zhang, and Karin Verspoor. 2024. Graph Transformers: A Survey. arXiv preprint arXiv:2407.09777 (2024).

[154] Feng Shi, Jian Cheng, Li Wang, Pew-Thian Yap, and Dinggang Shen. 2015. LRTV: MR image super-resolution with low-rank and total variation regularizations. IEEE transactions on medical imaging 34, 12 (2015), 2459–2466.

[155] David Silver, Aja Huang, Chris J Maddison, Arthur Guez, Laurent Sifre, George Van Den Driessche, Julian Schrittwieser, Ioannis Antonoglou, Veda Panneershelvam, Marc Lanctot, et al. 2016. Mastering the game of Go with deep neural networks and tree search. nature 529, 7587 (2016), 484–489.

[156] Youddha Beer Singh and Shivani Goel. 2022. A systematic literature review of speech emotion recognition approaches. Neurocomputing 492 (2022), 245–263.

[157] Kate A Smith-Miles. 2009. Cross-disciplinary perspectives on meta-learning for algorithm selection. ACM Computing Surveys (CSUR) 41, 1 (2009), 1–25.

[158] Andrea Soltoggio, Kenneth O Stanley, and Sebastian Risi. 2018. Born to learn: the inspiration, progress, and future of evolved plastic artificial neural networks. Neural Networks 108 (2018), 48–67.

[159] Yisheng Song, Ting Wang, Puyu Cai, Subrota K Mondal, and Jyoti Prakash Sahoo. 2023. A comprehensive survey of few-shot learning: Evolution, applications, challenges, and opportunities. Comput. Surveys 55, 13s (2023), 1–40.

[160] Dmitri Strukov, Giacomo Indiveri, Julie Grollier, and Stefano Fusi. 2019. Building brain-inspired computing. Nature Communications 10 (2019), 4838–2019.

[161] S Suganyadevi, V Seethalakshmi, and Krishnasamy Balasamy. 2022. A review on deep learning in medical image analysis. International Journal of Multimedia Information Retrieval 11, 1 (2022), 19–38.

[162] Yao Sui, Onur Afacan, Ali Gholipour, and Simon K Warfield. 2019. Isotropic MRI super-resolution reconstruction with multi-scale gradient field prior. In International Conference on Medical Image Computing and Computer-Assisted Intervention. Springer, 3–11.

[163] Ke Sun, Ciyuan Peng, Shuo Yu, Zhuoyang Han, and Feng Xia. 2024. From EEG Data to Brain Networks: Graph Learning Based Brain Disease Diagnosis. IEEE Intelligent Systems (2024).

[164] Quan Sun, Yufeng Cui, Xiaosong Zhang, Fan Zhang, Qiying Yu, Yueze Wang, Yongming Rao, Jingjing Liu, Tiejun Huang, and Xinlong Wang. 2024. Generative multimodal models are in-context learners. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 14398–14409.

[165] Quan Sun, Qiying Yu, Yufeng Cui, Fan Zhang, Xiaosong Zhang, Yueze Wang, Hongcheng Gao, Jingjing Liu, Tiejun Huang, and Xinlong Wang. 2023. Emu: Generative pretraining in multimodality. In The Twelfth International Conference on Learning Representations.

[166] Richard S Sutton and Andrew G Barto. 1998. The reinforcement learning problem. Reinforcement learning: An introduction (1998), 51–85.

[167] Amirhossein Tavanaei, Masoud Ghodrati, Saeed Reza Kheradpisheh, Timothée Masquelier, and Anthony Maida. 2019. Deep learning in spiking neural networks. Neural networks 111 (2019), 47–63.

[168] Annalisa T Taylor, Thomas A Berrueta, and Todd D Murphey. 2021. Active learning in robotics: A review of control principles. Mechatronics 77 (2021), 102576.

[169] Gemini Team, Rohan Anil, Sebastian Borgeaud, Yonghui Wu, Jean-Baptiste Alayrac, Jiahui Yu, Radu Soricut, Johan Schalkwyk, Andrew M Dai, Anja Hauth, et al. 2023. Gemini: a family of highly capable multimodal models. arXiv preprint arXiv:2312.11805 (2023).

[170] GLM Team, Aohan Zeng, Bin Xu, Bowen Wang, Chenhui Zhang, Da Yin, Diego Rojas, Guanyu Feng, Hanlin Zhao, Hanyu Lai, et al. 2024. ChatGLM: A Family of Large Language Models from GLM-130B to GLM-4 All Tools. arXiv e-prints (2024), arXiv –2406.

[171] StepFun Research Team. 2024. Step-1v: A hundred billion parameter multimodal large model. https://platform.stepfun.com/.

[172] Jessica AF Thompson. 2021. Forms of explanation and understanding for neuroscience and artificial intelligence. Journal of Neurophysiology (2021).

[173] Dagmar Timmann, Johannes Drepper, Marcus Frings, Michael Maschke, Stephanie Richter, MEEA Gerwig, and Florian P Kolb. 2010. The human cerebellum contributes to motor, emotional and cognitive associative learning. A review. Cortex 46, 7 (2010), 845–857.

[174] Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. 2023. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971 (2023).

[175] Huiling Tu, Shuo Yu, Vidya Saikrishna, Feng Xia, and Karin Verspoor. 2023. Deep Outdated Fact Detection in Knowledge Graphs. In IEEE International Conference on Data Mining Workshops (ICDMW). IEEE, Shanghai, China, 1443–1452.

[176] Mark Turner. 2014. The origin of ideas: Blending, creativity, and the human spark. Oxford University Press.

[177] Shimon Ullman. 2019. Using neuroscience to develop artificial intelligence. Science 363, 6428 (2019), 692–693.

[178] İlhan Uysal and Utku Kose. 2024. Explainability and the Role of Digital Twins in Personalized Medicine and Healthcare Optimization. In Explainable Artificial Intelligence (XAI) in Healthcare. CRC Press, 141–156.

[179] Frank J Van Rijnsoever and Laurens K Hessels. 2011. Factors associated with disciplinary and interdisciplinary research collaboration. Research policy 40, 3 (2011), 463–472.

[180] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. 2017. Attention is all you need. Advances in neural information processing systems 30 (2017).

[181] Staal Amund Vinterbo. 2004. Privacy: A machine learning view. IEEE Transactions on knowledge and data engineering 16, 8 (2004), 939–948.

[182] Oriol Vinyals, Charles Blundell, Timothy Lillicrap, Daan Wierstra, et al. 2016. Matching networks for one shot learning. Advances in neural information processing systems 29 (2016).

[183] Kailas Vodrahalli, Roxana Daneshjou, Tobias Gerstenberg, and James Zou. 2022. Do humans trust advice more if it comes from ai? an analysis of human-ai interactions. In Proceedings of the 2022 AAAI/ACM Conference on AI, Ethics, and Society. 763 –777.

[184] Rommy Von Bernhardi, Laura Eugenín-von Bernhardi, and Jaime Eugenín. 2017. What is neural plasticity? The plastic brain (2017), 1–15.

[185] Hao Wang and Dit-Yan Yeung. 2020. A survey on Bayesian deep learning. ACM computing surveys (csur) 53, 5 (2020), 1–37.

[186] Weiqi Wang, Zhiyi Tian, and Shui Yu. 2024. Machine Unlearning: A Comprehensive Survey. arXiv preprint arXiv:2405.07406 (2024).

[187] Wenqi Wang, Run Wang, Lina Wang, Zhibo Wang, and Aoshuang Ye. 2021. Towards a robust deep neural network against adversarial texts: A survey. ieee transactions on knowledge and data engineering 35, 3 (2021), 3159–3179.

[188] Xiangwen Wang, Xianghong Lin, and Xiaochao Dang. 2020. Supervised learning in spiking neural networks: A review of algorithms and evaluations. Neural Networks 125 (2020), 258–280.

[189] Xu Wang, Sen Wang, Xingxing Liang, Dawei Zhao, Jincai Huang, Xin Xu, Bin Dai, and Qiguang Miao. 2022. Deep reinforcement learning: A survey. IEEE Transactions on Neural Networks and Learning Systems 35, 4 (2022), 5064–5078.

[190] Xinxi Wang and Ye Wang. 2014. Improving content-based and hybrid music recommendation using deep learning. In Proceedings of the 22nd ACM international conference on Multimedia. 627–636.

[191] Yaqing Wang, Quanming Yao, James T Kwok, and Lionel M Ni. 2020. Generalizing from a few examples: A survey on few-shot learning. ACM computing surveys (csur) 53, 3 (2020), 1–34.

[192] X.ai. 2024. Grok-1.5 vision preview. https://x.ai/blog/grok-1.5v.

[193] Yaochen Xie, Zhao Xu, Jingtun Zhang, Zhengyang Wang, and Shuiwang Ji. 2022. Self-supervised learning of graph neural networks: A unified review. IEEE transactions on pattern analysis and machine intelligence 45, 2 (2022), 2412– 2429.

[194] Bo Xu, Longjiao Li, Wei Luo, Mehdi Naseriparsa, Zhehuan Zhao, Hongfei Lin, and Feng Xia. 2024. Beyond Linguistic Cues: Finegrained Conversational Emotion Recognition via Belief-Desire Modelling. In Proceedings of the 2024 Joint International Conference on Computational Linguistics, Language Resources and Evaluation (LREC-COLING 2024). 2318–2328.

[195] Bo Xu, Xiufeng Shi, Yueqin Yin, Zhehuan Zhao, Wei Zheng, Hongfei Lin, Zhihao Yang, Jian Wang, and Feng Xia. 2019. Incorporating user generated content for drug drug interaction extraction based on full attention mechanism. IEEE Transactions on NanoBioscience 18, 3 (2019), 360–367.

[196] Sulbha Yadav and Sudhir Dhage. 2024. TE-CapsNet: time efficient capsule network for automatic disease classification from medical images. Multimedia Tools and Applications 83, 16 (2024), 49389–49418.

[197] Shuangming Yang, Xinyu Hao, Bin Deng, Xile Wei, Huiyan Li, and Jiang Wang. 2018. A survey of brain-inspired artificial intelligence and its engineering. Life Research 1, 1 (2018), 23–29.

[198] Man Yao, Guangshe Zhao, Hengyu Zhang, Yifan Hu, Lei Deng, Yonghong Tian, Bo Xu, and Guoqi Li. 2023. Attention spiking neural networks. IEEE transactions on pattern analysis and machine intelligence 45, 8 (2023), 9393–9410.

[199] Junliang Yu, Hongzhi Yin, Xin Xia, Tong Chen, Jundong Li, and Zi Huang. 2023. Self-supervised learning for recommender systems: A survey. IEEE Transactions on Knowledge and Data Engineering 36, 1 (2023), 335–355.

[200] Dongyu Zhang, Minghao Zhang, Ciyuan Peng, and Feng Xia. 2022. Expressing Metaphorically, Writing Creatively: Metaphor Identification for Creativity Assessment in Writing. In Companion Proceedings of the Web Conference 2022. 1198 –1205.

[201] Guohe Zhang, Bing Li, Jianxing Wu, Ran Wang, Yazhu Lan, Li Sun, Shaochong Lei, Hai Li, and Yiran Chen. 2020. A low-cost and high-speed hardware implementation of spiking neural network. Neurocomputing 382 (2020), 106–115.

[202] Jianhua Zhang, Zhong Yin, Peng Chen, and Stefano Nichele. 2020. Emotion recognition using multi-modal data and machine learning techniques: A tutorial and review. Information Fusion 59 (2020), 103–126.

[203] Kexin Zhang, Qingsong Wen, Chaoli Zhang, Rongyao Cai, Ming Jin, Yong Liu, James Y Zhang, Yuxuan Liang, Guansong Pang, Dongjin Song, et al. 2024. Self-supervised learning for time series analysis: Taxonomy, progress, and prospects. IEEE Transactions on Pattern Analysis and Machine Intelligence (2024).

[204] Youhui Zhang, Peng Qu, Yu Ji, Weihao Zhang, Guangrong Gao, Guanrui Wang, Sen Song, Guoqi Li, Wenguang Chen, Weimin Zheng, et al. 2020. A system hierarchy for brain-inspired computing. Nature 586, 7829 (2020), 378–384.

[205] Xia Zhao, Limin Wang, Yufei Zhang, Xuming Han, Muhammet Deveci, and Milan Parmar. 2024. A review of convolutional neural networks in computer vision. Artificial Intelligence Review 57, 4 (2024), 99.